ИСТОРИЯ ПЕДАГОГИЧЕСКОЙ ТЕОРИИ ИЗМЕРЕНИЙ

Вадим Аванесов

Аннотация

Рассматриваются вопросы истории и теории педагогических измерений, уточняются цели, задачи, объект и предмет этой теории, проблемная ситуация. Главным тормозом развития педагогических измерений в России назван т.н. единый государственный экзамен (ЕГЭ). Исследованы причины краха его научного обеспечения. Многое, если не всё, делалось в нём вопреки педагогической теории измерений. Закономерно, что результаты такого экзамена оказались некачественными.

Введение

Когда игнорируются проблемы измерения,

результаты бывают далёкими от ожидаемых.

Maranell[1]

Восемь лет прошло с того времени, когда в первом номере нового российского научно-методического журнала «Педагогические Измерения» была напечатана статья «Основы педагогической теории измерений[2]». В статьи были впервые выделены три главные части (предмета) этой теории: понятийный аппарат (язык) теории, содержание и форма тестовых заданий. Никакая другая теория этими ключевыми вопросами педагогических измерений не занимается. Отсюда вытекает актуальность и перспективность построения педагогической теории измерений.

Ключевое место в статье заняло истолкование смыслов определения трёх главных понятий педагогической теории – «задание в тестовой форме», «тестовое задание» и «педагогический тест». Тест кратко определялся как система заданий возрастающей трудности. Судя по всему, эти смыслы не были восприняты. Поэтому вслед за первой статьёй по теории педагогических измерений публиковались новые статьи[3]. В частности, была предложена идея перехода от системы тестирования к системе педагогических измерений. Эта идея тоже не была замечена.

Различия между тестированием и педагогическими измерениями раскрываются в приводимых далее определениях. Идея перехода от тестирования к системе педагогических измерений возникла в результате сравнительного исследования вопросов методологии педагогических измерений[4], практики централизованного тестирования[5] и результатов единого государственного экзамена (ЕГЭ)[6].

Тесты имеют свою историю, которая предшествовала истории педагогических измерений. В литературе прошлого века чаще говорилось об истории тестов[7], заметно реже - об истории педагогических измерений. Эти две истории отличаются в той мере, в какой понятие «тестирование» отличается от понятия «педагогические измерения». Первое – это преимущественно практика применения тестов, второе – научное обеспечение и научная сторона этой практики, но более высокого научного уровня, включая шкалирование и умелую интерпретацию тестовых результатов.

В данной статье сделана попытка рассмотреть связь двух историй и двух теорий – тестов и педагогических измерений.

О взаимосвязи истории и теории хорошо написал Н. Чернышевский. Он сделал это на примере искусства: "История искусства, - писал он, - служит основанием теории искусства, потом теория искусства помогает более совершенной, более полной обработке истории его; лучшая обработка истории послужит дальнейшему совершенствованию теории, и так далее, до бесконечности... Без истории предмета нет теории предмета; но и без теории предмета нет даже мысли о его истории, потому что нет понятия о предмете, его значении и границах"[8].

Эта мысль является полезной и для понимания взаимосвязи интересующих нас двух историй и двух теорий – тестов и педагогических измерений.

Начало истории тестов: краткий обзор содержания опубликованных статей

Без истории нет теории.

Гегель

Вопросы истории тестов исследовались в цикле статей, напечатанных ранее в газете «Управление школой», а также в трудах В.М. Кадневского и других авторов.

Первая статья называлась «Из глубины веков»[9]. В ней отмечалось, что всякая попытка определить точное время возникновения тестов напоминает стремление географов найти точное начало большой реки, вытекающей множеством ручейков из обширного болота. Примерно так же обстоит дело и с историей тестов. Для изучения истории тестов вначале потребовалось изучить предысторию – то самое болото, из которого и вытекает их подлинная история. Начало тестоподобных проверок учебных достижений прослеживалось от середины III-го тысячелетия до н.э.

Во второй статье[10] родоначальником тестовых методов был назван Ф. Гальтон. Эта точка зрения была недавно поддержана и развита в статье В.М. Кадневского, В.Лемиш и Т.Ширшовой.[11]. В ней Ф. Гальтон был признан одним из основателей также и теории педагогических измерений. Он был тестологом, практиком и теоретиком, одновременно, привнёсшим идеи измерения, статистики и математики в зарождавшуюся тогда науку об измерениях интеллектуальных и, надо особо отметить, двигательных способностей личности.

В третьей статье писалось о российском опыте преодоления недостатка выставляемых оценочных баллов, а также о создании первого теста во Франции. В СССР следствием постановления ВКП(б) “О порядке окончания в 1932/33 учебном году в начальной и средних школах” стала процентомания, от которой российское образование не может оправиться и в наши дни. В постановлении отмечалось, что “проводимые испытания являются формой государственного и общественного контроля не только за работой учащихся, но и за качеством работы учителя и школы в целом”.

Это утверждение содержало две ошибки.

Первая - отождествление государственного и общественного контроля. Госконтроль обычно вырождается в бюрократическое мероприятие, как это сейчас произошло с ЕГЭ. Общественный же контроль опирается на широкое участие родителей, педагогов и профессионалов-тестологов. Такого контроля в России не было никогда.

Вторая ошибка заключается в установлении жёсткой связи результатов контроля с качеством работы учителей и школы. Но не всё, особенно в наше время, зависит от школы и от учителя. Многое зависит также от условий обучения и места жительства, в которых работает школа, от качества работы дошкольных учреждений, от уровня и качества обеспечения учебной техникой, много другого, в том числе, от наличия цифровых образовательных ресурсов Последних заметно не хватает, особенно на языках народов РФ.

Если условия образовательной деятельности неравные, то и экзаменационные требования к учащимся не могут быть едиными; требования должны быть дифференцированными в зависимости от содержания реально изученных курсов. Единого содержания уже почти нет, страна постепенно, отчасти вынужденно и стихийно переходит на уровневое образование. Органы управления образованием и научно-педагогические учреждения на эту тенденцию реагируют с отставанием.

С появлением ЕГЭ упомянутая идея постановления ВКП(б) 1923 года о контроле за работой учителя вновь начала ассоциироваться с качеством работы преподавателей. Не случайно появился документ Всемирного банка, призванный охладить пыл российских чиновников и разъяснить им смысл системы государственного контроля качества образования. «Задачей системы оценки качества образования (системы управления качеством), – написано там, – является не сбор информации в целях тотального контроля сверху, а мобилизация ресурсов школ для повышения качества. Поэтому создаваемые системы оценки должны… ориентироваться на самоконтроль школ и учителей как на важнейший ресурс повышения качества»[12].

Всякий метод государственного контроля кажется поначалу очень удобным власти, потому что он привычно работает исключительно на её стороне. Но при некачественном контроле такой метод имеет тенденцию оборачиваться своим эффектом в противоположную сторону. Особенно при отсутствии общественно-профессионального контроля. Это как раз и случилось с ЕГЭ. Как показывают результаты социологических опросов, ЕГЭ неуклонно теряет доверие со стороны основных групп населения страны.

В четвёртой статье[13] отмечалось, что практика тестирования в СССР характеризовалась серьезными противоречиями; по мере роста числа тестов и тестовых исследований имели место попытки торможения тестовой работы и даже запрета на распространение тестов. В 1936 году было принято Постановление Совета Народных Комиссаров под многозначительным названием “О педологических извращениях в системе Наркомпроссов”. Этот документ на долгое время затормозил применение тестов в СССР, мешал разработке и применению тестовых методов в сфере образования, профотбора и профориентации.

В США под теорией тестов понимались научные основы разработки тестов и тестовых заданий, в соответствии с двумя основными критериями качества тестовых результатов – надёжности и валидности. Эта теория начала развиваться более ста лет назад, вместе с психологической теорией тестов. Тогда это была одна общая теория - психологических и педагогических тестов. За рубежом тесты применялись и в социологических исследованиях[14].

В пятой статье говорилось о Постановлении Совета Народных Комиссаров и ЦК ВКП(б) от 3 сентября

Для сравнения, в той же статье приводились результаты применения тестов в профессиональном отборе авиационных специалистов США во время Второй мировой войны. Приводилась такая статистика: в Первую мировую войну только 2% потерь авиации были связаны непосредственно с боевыми операциями; 8% было потеряно из-за дефектов материальной части, а больше всего – 90% потерь – было вызвано профессиональной непригодностью тех, кто пилотировал самолеты[16]. Эти факты убедили многих в необходимости проведения профессионального отбора кадров посредством применения тестов. Один из самых активных участников этого процесса J.P.Guilford посчитал, что на каждый доллар, затраченный на эту программу, американский бюджет сэкономил тысячу долларов[17].

В шестой статье отмечалось, что запрещение педологии, а вместе с нею и тестов, стало одним из первых фактов идеологического давления на неугодные науки, научные направления и на отдельных ученых. В числе пострадавших от такого давления оказались авторы выпускавшихся в конце 20-х – начале 30-х годов сборников «Тесты: теория и практика». Это М.Я. Басов, М.С. Бернштейн, А.П. Болтунов, С.М. Василейский и другие. Как прозорливо отмечал в те годы П.П. Блонский, тесты – это больше, чем средство контроля; это средство рационализации школьного дела. Это мнение тоже не было услышано.

В седьмой статье[18] тестирование в СССР периода пятидесятых-семидесятых годов двадцатого столетия было охарактеризовано одним словом – застой. Что связано с общей тенденцией деградации CCCР. Причинами этой тенденции стали авторитаризм, национализм, ошибочная политика подбора управленческих кадров, в которой проявлял себя некий принцип, похожий на закон убывания плодородия почвы. В стране культивировался отрицательный подбор кадров, в соответствии с которым последующее поколение управленце оказывалось хуже предыдущего. Похоже, что с этим сейчас дела обстоят не лучше.

В последние годы в России делались попытки называть тестированием процесс применения так называемых контрольно-измерительных материалов (КИМов) ЕГЭ[19]. Хотя уже было неоднократно показано, что ничего измерительного в этих материалах нет[20]. Это лишь контрольные задания со скрываемой государственным органом мерой погрешностей результатов. Странным образом власть позволяет создателям КИМов ЕГЭ манипулировать словами и не показывать меру погрешности этих «материалов».

Педагогическое тестирование – это практическая деятельность по применению тестов в интересах личности и в целях улучшения качества образовательной деятельности. В данной статье педагогическое тестирование рассматривается как практическая сторона педагогических измерений. Как было отмечено, тестовые баллы – это результаты тестирования испытуемых, а не результаты педагогических измерений[21]. Поэтому их лучше называть исходными баллами испытуемых.

Обычный порок тестирования – нарушение прав личности на объективную информацию об уровне собственной подготовленности. Но здесь дело не в тестах, а в субъективизме тех, кто применяет тесты. Нарушение прав происходит по отношению не только к учащимся, но и к педагогическим коллективам, если от имени государства используются некачественные тесты, или, что ещё хуже, КИМы ЕГЭ, имеющие, как уже было неоднократно показано, высокие значения погрешностей измерений.

Начало истории педагогической теории измерений

Теория педагогических измерений включает в себя методические правила проведения тестирования, и кроме того, три важных направления научной деятельности: формирование языка этой теории, теория формы и вопросы отбора содержания тестовых заданий. И это ещё не всё. Подлинное педагогическое измерение появляется после тестирования испытуемых, в процессе шкалирования их результатов, а также в процессе шкалирования заданий по их существенным свойствам.

Исторически сложилось так, что теории педагогических измерений предшествовала разработка вопросов теории оценивания[22]. Оценивание можно определить как экспертный процесс выставления каких-либо баллов по заранее предписанным правилам. Автор этой статьи полагает научный статус оценивания ниже статуса педагогического измерения.

История возникновения общей теории измерений в общественных науках обстоятельно исследована Б.Райтом[23]. Он был уверен, что создаваемая им теория пригодна для всех общественных наук, включая педагогику. Так оно и случилось, и для того времени это был правильный ход мысли. Но рано или поздно, в науках возникают тенденции расширения и разделения, выделения собственного предмета. А потому естественным образом возникла проблема отделения педагогической теории измерений от общей теории измерений в психологии, социологии и в других общественных науках.

Теория педагогических измерений, как научная сторона процесса тестирования, стала развиваться с небольшим опозданием от теории тестов. Начало теории педагогических измерений положил Эдвард Торндайк[24],[25]. В своих трудах он затрагивал широкий круг философских, психологических и педагогических вопросов измерений, а также профессионального отбора.

Новаторство Э.Л.Торндайка проявилась в том, что он ранее других понял необходимость развития не только теории обучения, но также и двух других теорий – учения (самостоятельного изучения) и теории педагогических измерений. С появлением электронного обучения значимость этих двух теорий была осознана глубже, чем это было раньше.

Со времён Э. Торндайка в педагогическом сознании западных педагогов укоренялась мысль о том, что основная сфера применения тестовых форм – это не столько педагогический контроль, сколько самоконтроль в процессе собственного учения. В России эта мысль получила, можно сказать, противоположное истолкование, что связано с иным типом государственного устройства и систем управления образованием, таким типом, где роль бюрократии преувеличена, а роль науки и учёных минимизирована.

Исторически сложилось так, что первыми, больше ста лет назад, появились труды по психологической теории измерений. В 1936 году теоретики этого направления создали журнал высокого научного уровня, под названием «Psychometrika». Сейчас он издаётся и распространяется по всему миру. Затем стало развиваться общее направление «Психологическое и педагогическое измерение[26]». Язык и методы этого научного направления считались, видимо, по инерции, общими, равно применимыми в психологии и педагогике.

Позже последовало издание журнала по педагогическим измерениям[27], где были сделаны попытки выделить собственный педагогический предмет исследования и создать собственные педагогические методы. Успеха, однако, эти попытки не имели из-за отсутствия общей методологии педагогических измерений.

Три теории измерений

Разработка педагогической теории измерений проходила на основе имеющихся теорий. Сейчас наиболее известны три теории измерения.

1. Статистическая или, иначе, классическая теория тестов (classical test theory, CTT). Так она называлась в начале XX–го века.

Сейчас слова «классическая теория» – можно рассматривать как метафору. В подтверждение такого мнения можно привести два аргумента.

Во-первых, эта теория имеет точное, а не нынешнее метафорическое название. На английском языке она называется truе-score model of measurement. Поэтому её лучше называть не теорией, а моделью измерений.

Во-вторых, эта модель – перенос идей теории физических измерений на измерения в психологии и педагогике самого начала XX века. Отсюда упрощённая, мало реалистичная для наших дней, аксиоматика. Её точнее называть моделью истинного и ошибочного компонентов измерения. Разумеется, эта модель уже обросла тысячами исследований подлинно теоретического характера. Поэтому название «теория» реально существует, оно приемлемо, за исключением случаев сравнения этой модели с другими моделями педагогического измерения.

2. Вторую теорию можно очень условно перевести на русский язык как математическая теория измерений (Item Response Theory, IRT)[28].

3. Третья теория – больше чем теория. Это одновременно ещё методология и метрическая система. Потому она получила название метрической теоретической системы Г.Раша[29] (Rasch Measurement, RM). Когда эту модель измерения называют теорией, то и другие модели можно называть теориями, как это случилось, например, с IRT. Хотя другие, позже появившиеся модели измерения так и остались моделями. Да и более точное название IRT- это Latent Trait Model of Measurement.

Если за этими двумя названиями моделей измерения сохранять статус теорий, то отмеченное лексическое несоответствие лучше преодолевать созданием теории педагогических измерений, что и было сделано в статье журнала ПИ №1,

Все перечисленные – относительно общие теории, применимые не только в педагогике, но и в психологии, социологии, в медицинских и иных исследованиях. Все теории неоднократно рассматривались в журнале «Педагогические Измерения (ПИ)». Но общие теории не давали, и не могли дать, адекватные ответы на специфические педагогические проблемы. Нужна была специфическая педагогическая теория.

Неоднократно приходилось читать о делении теорий измерения на современные и не современные. С подобным подходом трудно согласиться, хотя бы потому, что устаревших (ненужных) теорий в педагогических измерениях нет. Каждая теория и сопутствующие ей методы дают свою, уникальную информацию о качестве заданий.

Например, в RM используется проверка заданий на соответствие требованиям модели Раша. Но получаемая при этом статистика оценки адекватности задания (Fit statistics) заметно уступает, по точности, значениям коэффициентов корреляции, используемых в статистической (классической) модели измерения для обоснования пригодности каждого заданий при включении его в тест. Не случайно во всех профессионально сделанных вычислительных пакетах значения коэффициентов корреляции приводятся. Сторонники RM иногда не принимают во внимание эту статистику, что надо признать как недостаток.

Другой пример. В IRT основной предмет исследования – формальные свойства каждого тестового задания. Эти свойства определяются по одной из математических моделей, применяемые к эмпирическим данным результатов ответов множества испытуемых на данное задание. Но ничего педагогического в этой математической модели нет, хотя в педагогических применениях математической модели это даёт хорошие результаты. В подлинном тестовом процессе все теории оказываются нужными и важными.

Поскольку перечисленные теории одинаково применимы к психологическим, социологическим, медицинским и другим измерениям, их можно отнести к общим междисциплинарным метрическим теориям. Следовательно, педагогическую теорию измерений можно тогда отнести к специальной педагогической теории.

В педагогической теории измерений выделены три предмета исследования: педагогические понятия теории, принципы отбора педагогического (предметного) содержания заданий и логические принципы формулирования педагогических тестовых заданий.

Существенные признаки педагогических измерений – это педагогически обоснованный отбор содержания теста, точный подбор формы заданий для того или иного содержания, система основных педагогических понятий теории[30]. Удивительно, что измерения педагогических латентных свойств, в том числе относящихся к педагогической науке, до сего дня некоторые зарубежные авторы считают задачами психометрики, с чем согласиться невозможно.

Проблемная ситуация

К началу ХХI века многие страны подошли с разным уровнем развития педагогической науки и образовательных технологий. Особенно заметными стали различия в вопросах изменения форм учебной деятельности, научной организации самостоятельной индивидуальной работы учащихся и студентов, в вопросах развития и применения цифровых образовательных ресурсов, новой учебной техники, новых методах обучения, контроля и самоконтроля.

Хотя к концу ХХ–го века научно-технический потенциал России был ещё высок, для многих специалистов стала очевидной отрицательная тенденция ослабления научно-технического и образовательного потенциала государства – вначале Советского, а затем и Российского. Низок международный рейтинг российских вузов[31]. Всё меньше иностранных студентов стали приезжать на учёбу в российские вузы. А это довольно объективный счётный показатель снижения привлекательности качества российского образования.

«Мы полностью утратили международную конкурентоспособность в этих сферах. Мы её просто потеряли. В СССР была хорошая наука и хорошее высшее образование, но их уже нет. То, что мы имеем сегодня, не соответствует даже минимальным требованиям". "На повестке дня - радикальные изменения"[32]. Эти слова можно истолковать как официальное признание краха образовательной политики, проводившейся в постсоветской России.

Одна из причин краха лежит в недостаточном понимании сути проблем педагогических измерений. Вот свежий пример. «Не ясно, – заявил переназначенный недавно на новый срок заместитель министра образования и науки РФ Игорь Реморенко, – почему так рьяно критикуется ЕГЭ[33]». Автору этой статьи и очень многим другим неоднократно приходилось писать о некачественности этого экзамена, о его отрицательном влиянии на систему образования. Асоциальные аспекты ЕГЭ зримо выявлены в докладе Общественной Палаты[34]. Разве этого мало для появления желания понять недостатки ЕГЭ?

Все соображения сходятся к тому, что некачественное управление сферой образования и проведение ЕГЭ явились главными причинами неприятия педагогической теории измерений, равно как и общего краха образовательной политики последних лет. А случившийся по воле Министерства образования и науки переход от некачественного Централизованного тестирования к проведению в России ещё более некачественного Единого государственного экзамена можно сравнить с отступлением из прошлого века в позапрошлый век.

В стране был сформирован ошибочный политический заказ на создание именно единого государственного экзамена и выделены большие деньги, которые направлялись в бывшее Министерство образования для организации работ. Никакого общественного контроля или проведения независимой экспертизы внутри страны не предполагалось.

Не случайно, что за прошедшее время педагогическая теория измерений не получила в России официального признания. Её не принимали и не отвергали, не ругали и не хвалили. Те, кто занимались единым государственным экзаменом (ЕГЭ), её просто не замечали, как не замечали и другие исследования, сопутствующие этой теории. Похоже, что была уверенность в возможности обойтись без всего этого. Как показало прошедшее время, случилось прямо противоположное: теория вполне обошлась без таких специалистов и продолжает развиваться, а вот ЕГЭ, оставленный сейчас без должного теоретического обеспечения, проявляет всё больше признаков стагнации. Теория, в отличие от практики, может существовать независимо от мнения отдельных лиц или даже мнения целого министерства, как это случилось в России.

Судя по возникшей ситуации, причину незаинтересованного отношения к педагогической теории измерений надо искать не в самой теории, а в ЕГЭ, который был создан бывшим Министерством образования РФ, вопреки положениям данной теории. В результате такого рода бюрократической деятельности произошла обычная подмена качественного тестового метода измерений некачественным ЕГЭ.

Вторую причину отторжения теории можно усмотреть в проводимой в последние годы образовательной политике, слепо отметающей всё, что не укладывается в рамки принятых в ней догматов. Например, когда в Японии заметили что национальные экзамены вызвали серьезное падение уровня образования, там их отменили[35]. Государственные экзамены, в отличие от Национальных, наносят ещё больший ущерб. И действительно, в России государственные экзамены оказались разрушительными для дела образования, но здесь нет никакой возможности их отменить. Власть не слышит мнения учёных и педагогов[36].

Вместе с тем, возникшая проблемная ситуация в некотором смысле обострила рефлексию относительно сути ЕГЭ и педагогических измерений, что начало способствовать поиску аргументов в пользу создания в России других, подлинных методов педагогических измерений. Вероятно, это и есть один из немногих плюсов ЕГЭ. Остальное - минусы.

ЕГЭ - главный тормоз развития педагогических измерений

С началом проведения в России единого государственного экзамена возникла потребность как-то обосновать применение своеобразных, придуманных там т.н. контрольно-измерительных материалов (КИМов) ЕГЭ.

ЕГЭ пытались сделать похожим на педагогические измерения, но это было только в самом начале. Тогда ещё делались некие попытки поиска подходящей для него научной основы, однако единства или хотя бы приемлемых взглядов в стане разработчиков ЕГЭ так и не было.

Поначалу разработчики не смогли определиться с формами – это будет экзамен или тест? Работники бывшего Центра тестирования настаивали на знакомой им тестовой форме технологичного единого государственного тестирования, в то время как педагоги-предметники, впервые привлечённые к разработке заданий для ЕГЭ, склонялись, наоборот, к тому, что им было известно и понятно – к нетехнологичной, экзаменационной форме вопросов.

Поскольку успех всего дела на первом этапе в большей мере зависел от предметников, чиновники Минобразования приняли их сторону, хотя это был тупиковый выбор. Таким образом, на самом раннем этапе возникновения ЕГЭ победили сторонники не тестовой, а экзаменационной формы. Этому способствовало и общее отрицательное отношение к тестам, которое сложилось в России давно. И такое отношение из-за ЕГЭ снова начало укрепляться в России. В подтверждении правильности этого мнения приведём выдержки из решения Всероссийской конференции математиков:

«Многие недавние решения и проекты руководителей образования вызывают у нас серьезное беспокойство. Прежде всего, это переход на 12-летнее обучение, замена конкурсного экзамена единым тестом. Мы опасаемся, что они не улучшат образование, но, наоборот, приведут к снижению его уровня». За проведение единого экзамена по математике выступило 22 участника конференции, против – 88. Всего участвовали в голосовании 131 участников конференции[37]».

Крах научного обеспечения ЕГЭ

На первых порах странный гибрид экзаменов и тестоподобных форм в ЕГЭ дал повод руководителям бывшего Министерства образования утверждать об оригинальности избранного ими пути. После многократной критики автором этой статьи утверждения такого рода там затихли, а информация о качестве таких материалов стала засекреченной. Она и теперь является главной тайной Министерства образования и науки. Однако по изредка появляющимся фрагментарным данным, качество контрольных «материалов» там остаётся ниже всякой критики. В них нет ничего метрического.

Необученные вопросам теории педагогических измерений, и в частности, не понимающие логику тестовых форм, методисты-предметники создали затем такие задания, которые сразу же пробили огромную брешь в качестве Единого государственного экзамена. Часть заданий была алогичной[38], часть ответов в заданиях легко угадывалась. В итоге госэкзаменуемые с низкой подготовкой незаслуженно получали сравнительно высокие баллы.

Вторая и третья части этого госэкзамена, в силу нетехнологичности используемых форм, потребовали гигантских затрат времени, ручного труда и бюджетных средств, породило субъективизм в оценках и множество ошибок, но министерство образования утвердило всё-таки такой вариант единого экзамена, надеясь со временем разобраться и в этом вопросе.

В качестве уступки оппонентам-сторонникам технологичного тестирования было решено использовать тестовую форму заданий, более или менее апробированную к тому времени в бывшем Центре тестирования. Тестовую форму заданий создатели ЕГЭ пытались использовать для самой лёгкой по содержанию, первой части Единого государственного экзамена.

Небольшое отрезвление от отождествления тестов и КИМов ЕГЭ последовало также после смены руководства Рособрнадзора. Было заявлено, что тестирование и ЕГЭ не следует рассматривать как синонимы[39]. После чего процесс размежевания тестов от КИМов пошёл с заметным ускорением.

С годами КИМы всё больше скатывались к традиционному экзамену. В итоге ЕГЭ оказался вовсе вне какой-либо метрической теории и вне внятно артикулированных наук – как педагогики, так и педагогических измерений. Были потуги создать что-то вроде КИМологии, но и они провалились. Отсутствие научной поддержки сыграло для ЕГЭ губительную роль. В научных публикациях неоднократно приводились факты некачественности результатов этого экзамена, отягощённые к тому же многочисленными фактами асоциальности самой процедуры проведения ЕГЭ[40].

Для научного обеспечения проведения ЕГЭ при бывшем министерстве образования РФ было создано специальное научное заведение – Федеральный институт педагогических измерений (ФИПИ). Как следует из редких научных публикаций этого института, одни сотрудники и авторы, вслед за руководителями министерства образования и Рособрнадзора, называли упомянутые КИМы ЕГЭ тестами. Другие считали, что говорить о ЕГЭ, как о тесте, рано (с.34). Третьи полагали, что «контрольные материалы для Единого экзамена не сводятся к тестам в узком смысле слова» [41].

В общем, там воцарилась неразбериха, итогом которой стала некая псевдонаучная деятельность, которая больше всего подходила под название ещё одной псевдонауки - «ЕГЭведение». Кредо этой псевдонауки можно усмотреть в такой цитате: «КИМы – это стандартизованная экзаменационная работа, создаваемая в соответствии с требованиями теории педагогических измерений, позволяющая с достаточной объективностью и надёжностью провести независимую государственную аттестацию выпускников образовательных учреждений и отбор абитуриентов вузов»[42]. Казалось бы, необходимость теории, как основы ЕГЭ, признаётся, но только на словах. Реальные результаты оказались диаметрально противоположными.

Получалось, что ЕГЭ позволит единым набором КИМов провести аттестацию и приём в вузы, якобы в соответствии с требованиями этой самой теории. В то время как требования не только педагогической, но и любой другой теории измерений в общественных науках были, наоборот, в том, что для повышения точности измерений уровень трудности заданий должен соответствовать уровню подготовленности испытуемых. Чем больше соответствие, тем выше точность педагогических измерений.

В ЕГЭ это требование нарушалось. Научные аргументы сторонники ЕГЭведения слушать не хотели, ибо тогда сразу обрушилась бы вся ошибочная конструкция, которую они выстроили. Если бы эту конструкцию не подпирали чиновники профильного министерства. Эти боялись возможного гнева верховной власти за выпуск бракованного изделия. А потому скрывали всё, что только можно скрыть.

Под название «КИМы ЕГЭ» можно подвести любой «материал» – задачи, вопросы, упражнения и т.п. – всё это действительно материалы, но не для создания методов педагогических измерений. Создание КИМов можно охарактеризовать как деятельность, лишь похожую на измерение, но судя по имеющимся фактам, не соответствующую научному процессу педагогических измерений. В то время как создание теста – это разработка научно обоснованного метода педагогического измерения.

Основные ошибки были сделаны на первом этапе.

Вот выдержки из статьи, предназначенной для научного обеспечения ЕГЭ: «Согласно общему решению, выработанному рабочей группой и коллективами авторов, в

Мнения разделились при оценке трудности контрольных измерительных материалов, которую, как и следовало ожидать, вузовские педагоги считают недостаточной, а школьные — избыточной и предлагают облегчить аттестационную часть теста. Различаются точки зрения по поводу оптимального числа частей КИМ. Многие рекомендуют включить в них дополнительную особо трудную часть для отбора абитуриентов по профилирующим дисциплинам в престижные вузы, причем перед выполнением этой части заданий предлагают делать перерыв[43]...»

Три противоречивых основания, разделяющие задания одного метода не по содержанию и уровню трудности, а по признаку формы, принятые общим решением всех, без исключения, разработчиков в основу создания одного ЕГЭ – достаточное условие для провала этого государственного экзамена. Если бы не было мощной поддержки чиновников.

Подтверждающие фактические результаты о полной метрической бездарности созданного ЕГЭ появились к моменту выхода в свет второго номера журнала «Педагогические Измерения». Данные оказались ошеломляющими. Тем не менее, сенсационная статья не могла быть опубликована в журнале по причине несогласия авторов с редакционными правками. Тем не менее, ввиду важности этой статьи для истории ЕГЭ и педагогических измерений, она сохранилась в редакционном портфеле журнала.

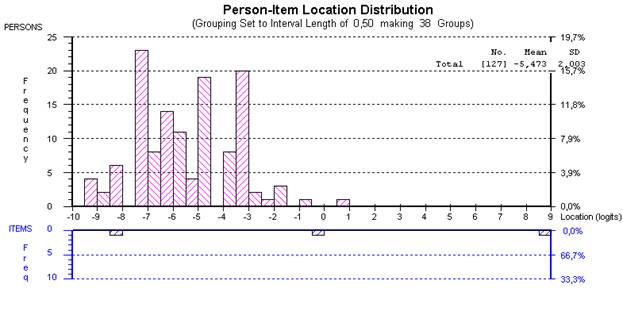

Вот выдержки из той неопубликованной статьи, в которой были визуализированы результаты влияния трёх единогласно избранных оснований (факторов) при создании ЕГЭ[44]: «На рис. 1 представлены две гистограммы. Первая (вверху) свидетельствует о распределении уровня знаний учащихся, вторая гистограмма (внизу) – о среднем уровне трудности заданий трёх частей КИМа - А, Б и С.

Рис. 1. Соответствие[45] между уровнем знаний учащихся и трудностью частей А, Б и С по математике

Рис. 1. Соответствие[45] между уровнем знаний учащихся и трудностью частей А, Б и С по математике

Вот что писали авторы той статьи. Цитата: «На этом рисунке по оси абсцисс откладываются значения латентной переменной (уровень знаний математики и уровень трудности частей теста), по оси ординат – число регионов (вверху) и число частей теста[46] (внизу). С левой стороны оси ординат указаны абсолютные значения регионов/частей теста, а с правой – соответствующие относительные величины (проценты).

Из рис. 1 следует, что уровень трудности части А теста ниже, а уровень трудности части Б теста – выше среднего уровня знания математики по регионам. Уровень трудности части С имеет запредельное значение и значительно превышает уровень знания математики в регионах. С точки зрения точности измерения латентных переменных, средняя трудность теста не должна отличаться от среднего уровня знаний учащихся более чем на 1 логит[47]. В данном случае уровень трудности теста на 5,47 логита превышает средний уровень знания математики учащихся в регионах. Это означает, что тест[48] неэффективен с точки зрения точности измерения – точность измерения уровня знаний по математике у этого значительно ниже точности того теста, который бы соответствовал уровню знаний учащихся по математике, при прочих равных условиях».

По мере выявления кардинальных различий между КИМами ЕГЭ и тестами сторонников тестов постепенно отодвигали от разработки КИМов ЕГЭ, в то время как влияние сторонников традиционной экзаменационной формы усиливалось. Это обстоятельство сыграло для государственного экзамена отрицательную роль. В научном отношении он оказался без какой-либо основы вообще.

Хотя тогда использовалась и наукообразная лексика типа «тест», «шкалирование», т.н. «калибровка заданий» и т.п. С годами исчезла и эта лексика. КИМы ЕГЭ всё больше скатывались к традиционному экзамену. Таким дорогостоящим образом исправлялась допущенная в самом начале ошибка совмещения экзамена и тестовой формы, а также совмещения трёх, сильно различающихся, уровней оценивания в одном ЕГЭ. Это стало торжеством абсурдного, с метрической точки зрения, мышления!

После 2005 года научные публикации по метрическим вопросам ЕГЭ, по существу, прекратились, и это стало началом кризиса. Федеральный институт педагогических измерений начал реально превращаться в методический центр по созданию некачественных КИМов ЕГЭ.

Новая история теории педагогических измерений

Автору этой статьи жил в период возрождения в СССР тестов и теории педагогических измерений, был активным участником этих событий.

Можно было бы сказать, что педагогическая теория измерений разрабатывалась в ответ на запрос образовательной педагогической практики. Но в свете её фактической невостребованности такое утверждение было бы скорее неправдой, чем правдой. Тем не менее, началом целенаправленных исследований по созданию именно педагогической теории измерений в России можно считать решение бывшего Комитета по высшей школе о создании Учебного центра при Исследовательском центре бывшего Госкомитета СССР по высшей школе.

Конечно, некоторые авторы могут возразить, что и раньше были публикации, тяготеющие больше к вопросам теории педагогических измерений, чем к вопросам практики тестирования. Но там всё-таки было больше тяготения к теории тестов. Здесь в качестве отправного пункта принят факт создания специализированной кафедры педагогических измерений в упомянутом Учебном центре. Насколько известно, в истории СССР, а затем и России, создание специализированной кафедры в научном учреждении случилось впервые.

Подходящих учебных материалов на русском языке тогда не было, а то, что имелось в печати, для учебного курса не годилось. Такие материалы пришлось создавать в процессе работы кафедры. Началась целенаправленная работа по исследованию возможностей тестовых форм для улучшения качества учебного процесса в вузах. Первым заметным итогом той работы стало учебное пособие для профессорско-преподавательского состав вузов[49]. Именно в том пособии были сформулированы и раскрыты вопросы истории, теории, методики и практики педагогического контроля.

В те годы писать о тестировании и педагогических измерениях не было принято. У многих ещё хранился в памяти упоминавшийся выше запрет на применение тестов. Отсюда и вынужденная редакционная замена непривычных понятий «тестирование» и «измерения» на приемлемые тогда понятия «проверка» и «контроль».

Система педагогических измерений включает в себя всю научную составляющую разработки и применения тестов для получения качественных тестовых результатов и последующего шкалирования, проведение рейтинга, мониторинга и создания качественных показателей образовательной деятельности. Основной предмет педагогической теории измерений – разработка качественных тестов для измерения уровня и структуры подготовленности учащихся и студентов. Такие тесты используются почти во всех современных образовательных технологиях.

Исходные понятия теории педагогических измерений

В тот период было начато решение несколько проблем педагогических измерений[50]. Первой из них стала проблема разработки исходных понятий теории[51]. Понятия педагогической теории измерений целенаправленно начали формулироваться в период написания автором этой статьи диссертации на соискание учёной степени доктора педагогических наук. Для того чтобы избежать обычной путаницы в толковании сути рассматриваемых научных положений, необходимо было с самого начала дифференцировать два главных понятия: педагогическое тестирование и педагогические измерения.

Педагогическое измерение - это преимущественно научная деятельность, результатом которой является методология и теория организации практического тестового процесса, такого, который позволяет в итоге, получить объективированные результаты на интервальной, а возможно, и на пропорциональной[52] шкале.

Педагогический тест – это научно обоснованный и технологичный метод исследования результатов учебной деятельности посредством системы заданий возрастающей трудности, позволяющей качественно оценить структуру и измерить уровень подготовленности испытуемых.

В учебном процессе преимущественно применяются не тесты, а задания в тестовой форме. Если последние сделаны правильно, с учётом формальных, содержательных, логических и семантических требований. Но правильная разработка заданий в тестовой форме встречается редко. То, что сейчас иногда называют «тестами ЕГЭ», не является ни тестами, ни педагогическими измерениями[53].

Н.Ф.Ефремова считает, что тесты являются наиболее эффективной и объективной формой оценивания знаний[54]. Она относит тест не к формам педагогического измерения, а формам оценивания, таким, например, как экзамен, зачёты, КИМы ЕГЭ и т.п. С этим трудно согласиться. Отнесение разных объектов к одному классу может способствовать лишь риску потери уникальных свойств теста, в отличие от экзаменов и пр.

Тесты обычно являются средством итогового, по содержанию, внешнего контроля. В России методом внешнего, относительно школ, контроля стал Единый государственный экзамен. Но, по сути, это не тест и не экзамен, в обычном понимании смысла этих педагогических форм[55].

Измерения можно также определить как процесс перехода от изучения интересующего свойства к созданию переменной величины, являющейся операциональным выражением данного свойства. Педагогические измерения имеют дело с латентными педагогическими свойствами личности, формируемыми в процессе образовательной деятельности и воспитания.

В теории педагогических измерений утверждается: качество измерения тем выше, чем лучше уровень подготовленности испытуемого соответствует уровню трудности заданий. Объективность педагогических измерений возникает как следствие интеграции методов обоснования надёжности и валидности тестовых результатов с методами шкалирования.

Результат измерения интересующего свойства выражается точкой на прямой линии, представляющей меру интересующего свойства. Отсюда и возникло одно из самых коротких определений педагогического измерения[56].

Цели и задачи педагогических измерений

Вторая проблема, которая решалась в последние годы – это формулирование целей и задач.

Сейчас цели тестирования и педагогических измерений лучше разделять. Цель тестирования – получение тестовых результатов уровня подготовленности испытуемых, цель же педагогических измерений, в основном – получение шкалированных значений уровня подготовленности испытуемых и уровня трудности заданий.

Цели педагогических измерений можно разделить на метрические, педагогические, психологические и социально-политические.

Пример метрической цели – построить шкалу уровня подготовленности испытуемых или шкалу уровня трудности заданий. В рамках метрической цели нередко используется сравнительно узкое, фокусированное определение цели педагогического измерения – как позиционирование испытуемого на прямой линии, представляющей латентную переменную величину[57].

Для позиционирования испытуемых на шкале их надо тестировать посредством заданий, определяющих переменную величину, а затем посредством шкалирования убедиться в том, что полученные тестовые результаты помогают определить место испытуемого на латентной переменной величине.

Пример педагогической цели – провести классификацию испытуемых по уровню их подготовленности, для комплектования уровневых классов учащихся школы.

Психологи используют тестовые результаты в целях выявления психологических затруднений в учебном процессе.

И, наконец, пример социально-политической цели – применение тестов для обеспечения равного доступа учащихся к качественному образованию. Для достижения последней цели вместо педагогических измерений в Росси стали использоваться некачественные КИМы ЕГЭ.

Основную задачу педагогических измерений Ю.Н. Каргин видит в поиске оптимальных оценок показателей подготовленности испытуемых и трудности заданий по наблюдаемым результатам тестирования[58].

С момента возникновения психометрики считается, что латентная переменная величина образует так называемый континуум измеряемого свойства[59]. Это означает непрерывность значений интересующего свойства на шкале, отсутствие каких либо ограничений на принимаемые значения слева и справа от среднего арифметического результата.

«Контрольно-измерительные материалы» обернулись метафорой, не содержащей в себе ничего метрического. В реальности был только госконтроль посредством преимущественно нетестовых заданий. Противоречия между теорией педагогических измерений и практикой разработки КИМов ЕГЭ скрыть не удавалось.

Образовательно-политический фактор

В российской системе образования одновременно сосуществуют при процесса, три состояния: реформа, застой и откат назад[60].

Действительно, в России уже много лет мирно уживаются три названных процесса, три состояния: реформа, застой и откат назад или иначе, деградация образования. Это вызвано образовательной политикой, действующими силами и традициями. Развитие образования востребовано родителями и общественностью, обеспечивается педагогами-новаторами, снизу, разрушительные же реформы навязываются бюрократией.

А потому в России, в какой-то день, всё может превратиться в политический фактор, даже ЕГЭ и теория педагогических измерений. Высокие значения погрешностей получаемых оценок ЕГЭ оказались неприемлемыми для экзаменуемых и их родителей. На дефекты ЕГЭ в Правительстве РФ не обращали должного внимания[61]. Вопрос качества ЕГЭ власть не считает важным. А потому этот вопрос с момента возникновения некачественного ЕГЭ стал постепенно превращаться в фактор ошибочной образовательной политики. Наверное, поэтому перед началом ежегодного государственного экзамена высшие руководители страны обещают его улучшить.

В.В. Путин признал, что существует очень много проблем с Единым государственным экзаменом, которые надо как-то решать[62]. Но вслед за этой сентенцией ничего путного не последовало. Д.А.Медведев неоднократно заявлял о необходимости разобраться в сути проблем, возникающих с проведением ЕГЭ[63] и о корректировке[64] этого экзамена. Была даже создана Кремлёвская комиссия по ЕГЭ, которая тоже не смогла в нём что-то улучшить.

Никто так и не объяснил гражданам – что конкретно нужно изменить в этом ошибочно скроенном экзамене, у которого по сей день нет ни автора, ни проекта, ни теоретического обоснования, ни научно проверенных результатов, но на который вхолостую тратится много государственных денег – по некоторой информации, порядка 33 миллионов рублей в год.

Похоже, что В.В.Путин и Д.А.Медведев теперь решили дистанцироваться от этой политически проигрышной темы, поскольку процент населения, поддерживающий идею проведения ЕГЭ, с каждым годом снижается.

В 2012 году очередные обещания улучшить ЕГЭ было поручено дать главе администрации Президента РФ Сергею Иванову. В его речи прозвучали элементы критики. Ещё критичнее выступил новый министр образования и науки, который в довольно жёстком тоне заявил, что «российские научные и образовательные организации за последние 20 лет оказались полностью неконкурентоспособными. А потому нуждаются в радикальной реформе[65]».

Это был ответ на критику образовательной системы со стороны Г. Грефа. Последний, в частности, заметил, что российские вузы "принимают дубов, а выпускают липу"[66]. Министр мог бы ответить на это, что «дубы» и «липы» появились в огромных количествах после того, как в Центре стратегических исследований, возглавлявшимся ранее Г. Грефом, возникла сомнительная идея проведения в России ЕГЭ. Но он так не ответил.

Ввязавшись в проведение ЕГЭ без должной теоретической проработки проблемы, бывшее министерство образования допустило стратегическую ошибку. Были келейные обсуждения, оппонентов не слышали, да и слушать не хотели. В общем, всё было так же, как и сейчас. Всё это – последствия своеобразного стиля работы. А потому ошибки в управлении образованием продолжают множиться.

О необходимости изменений немало говорилось и бывшими министрами. Например, в 2006 году А.Фурсенко признал, что, например, качество содержания российского образования совершенно не отвечает современным требованиям, и что 80 % учебников допускаться к обучению не должно. После чего он допускал эти учебники в школу и продолжал управлять сферой образования ещё шесть лет, ничего не сделав для исправления ситуации. Итог таков – учебники в России становятся всё хуже и хуже[67], образование же продолжает деградировать.

Не было ясности в ключевых целях и задачах проводимых реформ, в методах и формах образовательной деятельности, в критериях достижения обтекаемо сформулированных целей. В общем, во всех российских образовательных реформах последних 20-ти лет не было заметной опоры на существующие теории и методологии. Это были бюрократические реформы.

С годами ЕГЭ всё больше удалялся от требований, предъявляемым к педагогическим тестам, постепенно превращаясь, таким образом, в отчасти технологизированный массовый государственный экзамен. Это и есть его настоящее название. Используемые в нём т.н. контрольно-измерительные материалы не имеют признаков пригодности их для проведения педагогических измерений. И это уже доказанные факты, признавать которые Министерство не спешит.

Для бедного образовательного бюджета страны затраты на общественно неодобряемые «механизмы» самого управления оказались чрезмерными. Достаточно привести пример очень странных, трудно объяснимых затрат миллиарда рублей на спорные, если не сказать ошибочные, государственные образовательные стандарты. Можно также упомянуть издание дорогостоящих, но малополезных школьных учебников, не говоря уже о напрасных затратах на проведение ЕГЭ.

Очень спорны цели, задачи и методы создания Общероссийской системы оценки качества образования, как и уже произведённые на неё расходы. В итоге многие начинания чиновников подорвали доверие педагогической общественности к органам управления образованием. Эти органы могут качественно работать только в связке с общественно-профессиональными объединениями. Такова принципиальная сущность эффективного управления образованием и наукой.

Самой популярной в последние годы формой отторжения критики стало её замалчивание. Яркое подтверждение тому – нулевая реакция Министерства образования и науки на критический отчёт Общественной Палаты по результатам проведения ЕГЭ[68]. Поневоле возникает вопрос: зачем нужна Общественная палата, если власть не обращает внимания на её публикации и не принимает меры к исправлению возникшей ситуации? Отсутствует реакция и на критические статьи очень многих авторов.

С точки зрения теории педагогических измерений не бывает тестов в бланковом формате, одинаково точно измеряющих испытуемых разного уровня подготовленности. Это аксиома, которую никому ещё не удалось опровергнуть. Практика проведения некачественного ЕГЭ лишь подтверждает высокую погрешность получаемых оценок. От такого метода больше вреда, чем пользы. Такая погрешность оценок унизительна для страны. Дети имеют право на объективное измерение уровня их подготовленности. К сожалению, ЕГЭ это право нарушает. Кодекс профессиональной чести тестологов на Западе не разрешает использовать методы измерения с неизвестными показателями точности. В России это разрешает делать государство.

Сложившееся отношение к педагогическим измерениям абсурдно. Альбер Камю был прав, утверждая, что чувство абсурдности поджидает нас на каждом шагу. Мы уже много лет живём в антиобразовательном абсурде. И не видно пока просвета.

Основные результаты развития педагогической теории измерений

Как уже отмечалось выше, в работах последних лет был сформулирован понятийный аппарат педагогической теории, даны определения основным понятиям[69]. В качестве таковых выделены: задание в тестовой форме, тестовые задания, педагогический тест, испытуемые, тестовый процесс и содержание теста.

Предметом специального анализа стали также два других важных понятия педагогической теории измерений. Первое понятие – форма тестовых заданий. Это способ связи, упорядочения элементов задания. Тысячи примеров заданий четырёх основных форм, по многим учебным дисциплинам читатель найдёт в книгах автора[70],[71].

Показано, что логическое преимущество задания в тестовой форме, по сравнению с привычными вопросами экзаменов и госэкзамена, заключается в возможности превращения заданий в тестовой форме, после ответа испытуемых, в форму высказываний, истинных или ложных. Что создаёт надёжную основу для безошибочного дифференцирования испытуемых по уровню их подготовленности. Задания в тестовой форме выгодно отличается от обычных вопросов свойствами краткости, лучшей понимаемости смысла заданий, быстроты ответа учащихся, технологичности и эффективности.

В современном тестировании часто применяется дифференцирование испытуемых, по их ответам на каждое задание, не только на два, но и на большее число уровней. Это означает, что оценки даются за ответы правильные, неправильные, а также за частично правильные, с разными уровнями градации правильности. Такое оценивание ответов испытуемых называется по-английски Partial Credit Model. Оно имеет преимущества перед традиционным дихотомическим оцениванием посредством единицы и нуля. Главное преимущество – повышение надёжности тестовых результатов.

В качестве главной проблемы теории педагогических измерений названа разработка показателей качества и эффективности образовательного процесса.

Предмет педагогических измерений – уровень подготовленности испытуемых, который представляет собой единство знаний, умений, навыков, представлений. К понятию «подготовленность» можно отнести и часто используемое сейчас понятие «компетентность», представляющую собой прагматическую, или утилитарную, проекцию общего содержания образования.

При педагогических измерениях одно и то же свойство личности проявляется у разных испытуемых в разной степени. Обычно большему проявлению интересующего свойства ставится в соответствие и большее число. Реже поступают наоборот. Это бывает в случаях измерения общественно неодобряемых психологических свойств личности.

Кроме упомянутых выше результатов, в рамках развития педагогической теории измерений исследованы два традиционных критерия качества[72] – надёжности и валидности тестовых результатов, принятых в статистической теории измерений, и два относительно малоизвестных критерия – объективности[73] и эффективности[74] тестовых результатов, используемых преимущественно в RM и в адаптивном тестировании.

Сформулированы также принципы отбора содержания тестовых заданий[75], концепция пяти этапов тестового педагогического процесса[76], дана обновлённая классификация видов проверяемых знаний школьников и студентов[77]. Самое большое внимание в рамках разработки педагогической теории измерений было уделено вопросам формы [78] и принципам композиции тестовых заданий[79].

Три главных свойства заданий подлежат обязательному шкалированию и доскональному теоретическому и эмпирическому педагогическому исследованию – это уровень понимаемости смысла содержания заданий, мера их трудности и дифференцирующей способности. В России система такого рода метрической работы по изучению главных свойств педагогических заданий пока ещё не сложилась.

Не были обойдены вниманием и вопросы становления Национальной системы педагогических измерений[80]. Эту проблему Правительство РФ пыталось решить по-своему, и безуспешно, посредством ОСОКО (Общероссийской системы оценки качества образования), в центре которой стоял тот же ЕГЭ. Новые варианты ОСОКО не лучше прежней системы.

Определены пять основных направлений развития теории и практики педагогических измерений: демаркация (отграничение) педагогических измерений от контрольных материалов государственных экзаменов и от иных псевдометрических форм и методов, распространяемых сейчас в России под видом средств педагогических измерений; разработка новых форм тестовых заданий; существенное обновление содержание тестов и тестовых заданий; дальнейшая разработка критериев качества и эффективности педагогических измерений; улучшение языка педагогических измерений[81].

Выводы и предложения

1. История тестов и практический современный опыт стран с развивающимся образованием позволяют сделать вывод о необходимости скорейшей трансформации государственной формы контроля знаний учащихся и студентов в общественно-профессиональные формы.

2. История педагогических измерений подтверждает важную роль науки в организации систем контроля качества образования. Как показывает опыт внедрения российского ЕГЭ, без развития педагогических измерений существующие формы государственного экзамена вырождаются в примитивные бюрократические и асоциальные формы контроля.

3. Практика игнорирования педагогической теории измерений уже нанесла большой вред образовательной деятельности в России, и может нанести ещё больший вред, если образовательная политика не начнёт меняться в лучшую сторону.

4. Актуальны пять основных направлений развития теории и практики педагогических измерений:

Ø Демаркация (отграничение) педагогических измерений от контрольных материалов государственных экзаменов и от иных псевдометрических форм и методов;

Ø Разработка новых форм тестовых заданий;

Ø Существенное обновление содержание тестов и тестовых заданий;

Ø Централизованная разработка показателей качества и эффективности педагогических измерений и образовательной деятельности;

Ø Улучшение языка педагогических измерений.

5. Для каждого уровня обучения и для каждого учебного предмета предлагается создать тысячу тщательно отобранных по содержанию и технологичных по форме заданий возрастающей трудности, доведённых до каждого педагога и учащегося. Это тысяча способна радикально изменить качество массового образования к лучшему. Потому что появляется принципиально новая и эффективная единица учёта качества собственной учебной работы школьников и студентов.

6. Наличие двух и более тысяч таких заданий, умелое их применение для самостоятельной работы каждого учащегося, позволят совершить рывок в сфере образования. Потому что такие технологичные задания начинают выполнять главную функцию развития учащихся и студентов. Всё остальное лишь способствует этой функции.

Это предложение можно рассматривать как одну из современных электронных и метрических версий известного в прежней педагогике задачного подхода в обучении. Разработка систем заданий возрастающего уровня трудности, по всем изучаемым темам – проблема государственной важности.