ПРОБЛЕМА РАЗВИТИЯ ПЕДАГОГИЧЕСКИХ ИЗМЕРЕНИЙ

Вадим Аванесов

Каждая вещь известна настолько,

насколько её можно измерить.

У.Т. Кельвин

Хотеть совершить что-либо - значит хотеть всё то, что необходимо для достижения цели, в том числе хотеть приобрести те качества, которые нужны для воплощения замысла. Во всех прочих случаях вы не хотите, а просто стремитесь к чему-то, находитесь в плену собственной фантазии, сладостно упиваетесь задуманным.

Ортега-И-Гассет.[1]

Аннотация

В статье определены пять основных направлений развития теории и практики педагогических измерений. Первое – это демаркация (отграничение) педагогических измерений от контрольных материалов государственных экзаменов и от иных псевдометрических форм и методов, распространяемых сейчас в России под видом средств педагогических измерений. Второе направление – разработка вопросов формы тестовых заданий. Третье – содержание теста и тестовых заданий. Четвёртое направление – разработка критериев качества и эффективности педагогических измерений. И пятое направление – улучшение языка этой прикладной педагогической науки.

Развитию педагогических измерений препятствует проведение т.н. единого государственного экзамена, c его некачественными контрольными материалами. Эти материалы функционируют в России как бюрократическая подмена подлинных педагогических измерений. В статье обобщены ранее опубликованные факты и доказательства некачественности контрольных материалов российских государственных экзаменов.

Ключевые слова: педагогические измерения, демаркация, форма, содержание, язык, критерии качества результатов.

Введение

Педагогические измерения относятся к числу сравнительно малоисследованных направлений педагогической науки и образовательной практики. Они возникли в конце ХIХ-го – начале ХХ-го века за рубежом, вначале в Англии, США и Франции. В течение ста лет к этим трём странам добавились Австралия, Нидерланды, Израиль, Южная Корея, Япония. За прошедший век педагогические измерения превратились в одно из развивающихся направлений зарубежной педагогической науки.

В России сложилась иная ситуация. Здесь педагогические измерения заметного развития не получили. В ХХI век Россия вошла с контрольными материалами государственного экзамена, созданными на основе политически привлекательной, но метрически ошибочной идеи – одновременной оценки выпускников школ и абитуриентов вузов общим (единым) набором заданий единого государственного экзамена (ЕГЭ). Качественно измерить заметно различающиеся уровни подготовленности выпускников российских школ и абитуриентов вузов бланковыми методами не удаётся в течение вот уже десяти лет. Контрольные материалы превратились, по сути, в антагонистов подлинных педагогических измерений.

Проблемная ситуация

Зримым поворотным моментом к ухудшению ситуации с педагогическими измерениями стало решение Правительства РФ о проведении в стране единого государственного экзамена (ЕГЭ)[2]. В распоряжении Правительства РФ №910-з- объяснялось, что ЕГЭ вводится с целью обеспечения объективности и унификации итоговой аттестации и вступительных испытаний в системе профессионального образования[3].

Дело, казалось, нужное – обеспечение равного доступа граждан к высшему образованию и ликвидация разросшейся коррупции при приёме в вузы. Но идея унификации итоговой аттестации и вступительных испытаний в вузы не сочеталась с традициями российского образования, научными положениями социологии, педагогики, психологии и педагогических измерений, зато легко укладывалась в логику трансформации образовательного процесса в сторону усиления авторитарных, бюрократических элементов.

Ответом на такую трансформацию стал ежегодный рост число нарушений правил проведения ЕГЭ. Результаты фабрикуются в невиданных ранее масштабах, коррупция растёт, качество образования ухудшается. Информация о всех зафиксированных нарушениях в целом по стране и по отдельным территориям не публикуется; более десяти лет она остаётся скрытой образовательным ведомством.

Спорная, изначально, цель оценить, единовременно и качественно, разные по уровню подготовленности контингенты школьников и абитуриентов вузов не могла продуцировать позитивные результаты. Одновременно это делать можно, но качественно, бланковыми формами, нельзя. А потому не

случайно в реальном исполнении контрольные материалы для достижения этой спорной цели оказались некачественными.

Ошибочные цели введения единого государственного экзамена и некачественные инструменты достижения этих целей привели к тому, что в России педагогическое оценивание и педагогические измерения были заменены бюрократическим контролем посредством некачественных «материалов». Все исходные и подлинные результаты засекретили, после чего вместо разработки научно-обоснованных методов педагогических измерений и улучшения качества образования бюджетные средства стали тратиться на проведение государственного экзамена.

Сама идея отбирать абитуриентов одинаковыми «материалами» в разные вузы – тоже ошибочная и вредная. Если вузы разные, и туда идут студенты с разной подготовкой, то и задания должны быть разные по уровню трудности, такие, которые позволяют каждому вузу точнее отобрать искомый контингент. При проверке всех одним и тем же набором «материалов» точность оценок резко ухудшается. Это особенно сказывается на правой стороне распределения исходных баллов, у наиболее подготовленных испытуемых.

Неоднократные обращения автора этой статьи и многих представителей научно-педагогической общественности к чиновникам всех уровней с предложениями прекратить производство некачественных материалов и проведение единого министерского контроля уровня подготовленности выпускников школ и абитуриентов различных вузов, успеха не имели. Ответом было полное молчание. А это самый грубый способ защиты - притвориться глухим или непонимающим, как писал Э. Каннети: «Молчащий не раскрывается, но выглядит при этом опаснее, чем он есть на самом деле. В нём подозревают большее, нежели он скрывает. Он молчит, потому что ему есть что скрывать»[4].

И действительно, с научно-педагогической точки зрения идея ЕГЭ оказалась уязвимой[5]. Преобладание внешней заданности в целях, содержании и технологии образования приводит к ослаблению внутренней мотивации учеников… , к гиперболизации формальных ценностей образования – получение отметки, сдачи экзаменов, поступление в вуз, его окончание[6].

Ещё более идея ЕГЭ оказалась несостоятельной с точки зрения теории педагогических измерений. Похоже, что исполнители и чиновники не понимали сложности самой проблемы. Чтобы убедиться в некачественности заданий, с которых начинался на так называемый «эксперимент по ЕГЭ», достаточно взглянуть на один пример контрольного «материала», не имеющего ничего общего с педагогическими измерениями[7]. Такой плохой старт стал одной из причин неудовлетворительного финиша. Некачественные контрольные «материалы» ЕГЭ дискредитировали благие замыслы Правительства РФ.

Последовало вынужденное признание В.В.Путиным справедливости критики ЕГЭ, сделанное, однако, вместе с предложением совершенствовать этот экзамен[8]. Но как это сделать? Конструктивных предложений по совершенствованию госэкзамена, созданного без науки об измерениях и мало-мальски обоснованного научно-педагогического проекта[9], не было ни до, ни во время, ни после десятилетнего срока его проведения.

Между тем, подлинные трудности с проведением ЕГЭ связаны не только, и не столько с проведением экзаменов, сколько с контрольными заданиями. Завеса секретности, незаконно возведённая вокруг исходных, реальных результатов, обернулась отрицательным образом для всей страны, в виде повсеместного ухудшения образовательной деятельности.

В органах управления образованием не считали нужным отвечать на обращения, критику, или вступать в дискуссию со своими многочисленными оппонентами. Такого вызывающего отношения чиновников к своим оппонентам в истории России не было никогда. Это был новый стиль, утвердившийся в сфере управления образованием. Как отмечалось в литературе, особенно удручала полная глухота реформаторов к мнению педагогической науки и народа[10].

В ситуации заинтересованности большинства сторон процесса ЕГЭ в повышении баллов испытуемых любыми способами ЕГЭ начал саморазрушаться. В недавно опубликованном отчёте Общественной Палаты РФ перечислено семь слоёв социума, заинтересованных в завышении результатов ЕГЭ, общим числом в миллион человек[11].

В результате справедливая, казалось бы, идея проведения в России ЕГЭ, но бездарно исполненная, стала с каждым годом терять своих сторонников. Надо подчеркнуть, что в западных странах ЕГЭ нет. Там проводится независимое, общественно-профессиональное тестирование, текущий и итоговый компьютерный адаптивный контроль в самих образовательных учреждениях, автоматизированный учёт всех решённых заданий, каждым учащимся или студентом, используется также рейтинг.

А потому ловчить невозможно и незачем, потому что при приёме смотрят не только на бумаги и в кошелёк родителей, но и на реальные компетенции, которыми владеют поступающие в вузы. О подлинных учебных достижениях каждого абитуриента известно всё и в любое время. Вот истинная польза открытости результатов и образовательных технологий для возможного свободного развития каждого гражданина, в зависимости от его способностей, прилежания и учебной мотивации.

Влияние ЕГЭ и контрольных материалов российского государственного экзамена на систему российского образования оказалось отрицательным. Давно известно, что вред от некачественных оценок в сфере образования существенно выше, чем кажущаяся от них польза[12].

Ещё раз подтвердилось на практике мнение выдающегося русского учёного и педагога Н.И.Пирогова: «Я почти ежедневно убеждаюсь из опыта, что экзаменационное направление в наших училищах не приносит никаких благих результатов. Оно вредно, оно возбуждает наклонность в учащихся учиться для экзамена, а не для науки»[13]. Единый государственный экзамен довёл отмеченную наклонность до абсурда.

Странным образом, верховная власть дала исполнителям ЕГЭ право игнорировать всенародную, по существу, критику в их адрес, дала бюджетные средства на проведение асоциального бюрократического контроля[14] и на производство некачественной[15] продукции. И, сверх того, дала право не отчитываться должным образом о своей работе.

Тем не менее, В.В.Путин не потерял ещё надежды на возможность совершенствования госэкзамена. Его понять можно. В 2000 году ЕГЭ казался важным фактором образовательной политики, утверждения идей усиления борьбы с коррупцией и установления справедливых форм приёма в вузы. Спустя 11 лет этот фактор обернулся ростом коррупции, снижения социальных гарантий обеспечения реального доступа граждан к высшему образованию. Сейчас госэкзамен стал похож на тяжёлый чемодан без ручки, который нести неудобно, а бросить, похоже, жалко.

Только в последнее время власть стала видеть глубину ямы под названием ЕГЭ, вырытой ошибочными целями, негодными инструментами («контрольно-измерительными материалами») и бюрократическим режимом исполнения. Фактическое введение полицейских мер в образовательный процесс - незаконные обыски учащихся[16], слежка за детьми в туалетах[17] и т.п. – прямая дорога к разрушению не только ЕГЭ, но и нравственных основ российской педагогики и Российского государства.

Государственный экзамен теперь становится отрицательным предвыборным фактором. Уже давно надо было начать поиск достойного способа его прекратить[18], что могло бы дать некоторым избирателям новую надежду. Однако свой элемент неожиданности привнёс А.А.Фурсенко, заявивший, что этот экзамен – навечно! Неужели ему непонятно, что своеволие, которое позволяли себе чиновники все годы силового внедрения ЕГЭ, дошло до нетерпимых пределов. А потому его притязания увековечить бездарный ЕГЭ лишь ускорят созревание ситуации, о которой говорил известный классик: когда низы больше не хотят, а верхи уже не могут.

ЕГЭ провалился?

В критической литературе обнаруживается много мнений о провале ЕГЭ. В министерстве образования и науки, а также в Правительстве РФ, так не считают. Хотя и об успехах тоже благоразумно перестали говорить. Видимо, играет свою роль периодическая замена кадров главных неудачников-толкачей ЕГЭ. Очевидно, вопрос в критериях - что считать провалом? Президент РФ Д.А.Медведев и Председатель Правительства РФ В.В.Путин считают, что у ЕГЭ есть плюсы и минусы, но что в целом он эффективен[19].

Никто из них, а также из министерства образования и науки, не назвали конкретные минусы ЕГЭ, и что они считают нужным совершенствовать? Из чего можно понять, что их позиция имеет лишь общую, но не конкретно определённую направленность на сохранение этого экзамена. Но такая позиция не имеет положительной перспективы. Между тем, конкретные недостатки ЕГЭ уже давно были выделены и названы в доброй сотне научных работ многих авторов[20]. Но них не обращали внимания. Эта критика считалась маргинальной, а сами критики в кулуарных обсуждениях относились к маргиналам. На самом деле маргинальной и ригидной оказалась позиция разработчиков ЕГЭ[21] и их заказчиков.

Важным объективным свидетельством провала ЕГЭ стал уже упоминавшийся выше документированный отчёт Общественной Палаты РФ[22]. В нём, в общем, в очередной раз показана неприемлемость и абсурдность сложившейся бюрократически-режимной практики проведения ЕГЭ. Сделанные там выводы, ввиду документированности событий и обращений, никем не опровергаются, но и опять не принимаются чиновниками, как нужные и полезные для исправления положения дел. В общем, для постсоветской России – это обычная практика. Как тогда совершенствовать ЕГЭ? В этих условиях он и начал разваливаться.

Ссылаясь на выводы независимой общественной комиссии, куда входил и автор этого доклада, С.М. Миронов заявил, что эксперимент по введению единого госэкзамена в стране провалился[23]. «ЕГЭ не устранил коррупцию при поступлении в вузы и не позволил объективно выставлять оценки выпускникам школ», - пояснил он. Судя по смещению его с должности Председателя Совета Федерации, последовавшим вслед за этим, эти его правильные слова пришлись не ко двору.

В.В. Черников тоже считает, что попытки повышения качества обучения через введение ЕГЭ провалились. Как известно, считает он, в тонущем корабле никакие прогрессивные способы мытья стаканов в камбузе не спасают корабль. И пока критерии работы системы образования не будут напрямую встроены в стратегию выживания социума, результат будет плохим[24].

Все попытки властей собственными силами улучшить ситуацию и остановить разрушительный процесс оказались неудачными; они принесли лишь новые, очередные трудности. Это следствие системных дефектов самого российского государственного экзамена и используемых там материалов. На критику дефектов разработчики этих материалов не реагировали должным образом, как будто они жили в другом государстве. В таком асоциальном варианте ЕГЭ был, конечно же, обречен на провал[25].

Реакция на этот прогноз была неожиданной. Вместо привычного молчания в Министерстве образования и науки РФ, без какого-либо признания ошибочности ЕГЭ, тихо и быстро отказались от идеи единых экзаменов для большинства школьных предметов, равно как и от единых контрольных материалов. И в нарушение закона переналадили большинство единых экзаменов только на приём абитуриентов в вузы. А норму статьи закона о едином экзамене сохранили, похоже, лишь для двух предметов - русского языка и математики. Генпрокуратура и Министерство юстиции РФ заняли привычную отстранённую от ЕГЭ позицию.

К слову, оба упомянутых выше экзамена имеют наибольшие метрические погрешности. Остальные т.н. «единые» госэкзамены после такой операции фактически перестали быть едиными, а потому уже больше не применяются для итоговой государственной аттестации выпускников школ. Бюрократическая логика незатейлива: меньше экзаменов для выпускников школ, меньше двоек, меньше станет и неприятностей.

Хотя буква «Е» в аббревиатуре ЕГЭ для большинства экзаменов стала обречённой на фактическое вымирание, во всех бумагах и в средствах массовой информации она сохранялась. Пропагандистский прессинг создавал в социуме ложное представление, что единый государственный экзамен жив, и вечно будет жить. Случившаяся в министерстве образования и науки подмена большинства ранее единых экзаменов не едиными экзаменами осталась в Правительстве РФ и в Госдуме как бы незамеченной. А потому финансирование провальной затеи продолжается.

ЕГЭ провалили некачественные контрольные «материалы» ФИПИ

Для реализации правительственной идеи проведения единого государственного экзамена был создан Федеральный институт педагогических измерений (ФИПИ). Ему и была поставлена задача создать новые, доселе неизвестные в мире, методы унификации двух экзаменов. На наше предупреждение о ложности самой идеи и об ошибочности принятого правительственного распоряжения чиновники привычно не реагировали[26].

ФИПИ погрузился в бесплодный «эксперимент» на целых восемь лет, без опубликованной научной программы. Отчёта о результатах этого пролонгированного поиска нет, и, видимо, никогда не будет. К 2009 году терпение оппонентов и власти иссякло, а потому было приказано «Пора»! После чего материалы ФИПИ для единого государственного экзамена объявили пригодными для масштабного применения на массах школьников и абитуриентов, в «штатном», как было отмечено, «режиме». Смысл последнего слова был тогда явно не понят и не оценён должным образом. Никто не мог тогда предположить, что в ФИПИ создавался не научно-педагогический метод, как это должно было быть, а новый контрольно-бюрократический режим проведения массового государственного экзамена.

Отсюда становятся понятными две главные причины провала ЕГЭ: авторитарный бюрократический режим, установленный для его проведения, и некачественный инструментарий, созданный в ФИПИ для реализации такого режима контроля знаний.

Сам ФИПИ был превращён в исполнительный придаток Министерства образования и науки. В условиях зависимости от ошибочной воли чиновников институт не получил возможности стать подлинно научным учреждением. То же произошло с Центром тестирования, который стал, по той же воле, головной организацией Рособрнадзора по организационно-технологическому обеспечению проведения ЕГЭ и по трансформации исходных результатов ЕГЭ в производные. Надо было так менять результаты ЕГЭ, чтобы мало кто мог понять – что же происходит в реальности. После чего Централизованное тестирование, проходившее ранее на добровольной основе во многих регионах России, перестало существовать[27]. Оно стало частью бюрократического режима контроля.

Настоящие научные статьи и научные монографии по педагогическим измерениям в ФИПИ не готовились и не издавались. Похоже, что писать их там было некому или некогда. И сейчас на сайте института нет таких изданий. Бюрократическому режиму контроля знаний это и не надо. По полезности и информативности публикуемой научной литературы по проблеме педагогических измерений этот сайт целого института заметно уступает сайтам отдельных авторов.

Быстро нашлось размытое и ложное название производимым там изделиям: контрольно-измерительные материалы (КИМы) ЕГЭ. Размытое, потому что под название «материалы» можно подвести даже канцелярский чих, попавший на служебную бумагу. Ложное, потому что эти КИМы не являются ни тестами, ни обычными экзаменами[28], ни педагогическими измерениями[29].

В ситуации отсутствия объективной статистики и вакуума эмпирических данных, общественное обсуждение проблем ЕГЭ было искусственно направлено исключительно в бездоказательный мир мнений. Это позволяло инициаторам и лоббистам ЕГЭ несколько лет держать оборону. Факты качественности материалов они представить не смогли, а факты некачественности пришлось скрывать.

В данной статье сделана попытка собрать некоторые факты, указывающие на непригодность контрольных материалов ЕГЭ, в предположении, что это поможет, наконец, перевести общественный дискурс из сферы мнений в область бесспорных, эмпирически установленных фактов.

Начнём с того факта, что большинство единых госэкзаменов уже не дожили до прогнозированного автором этой статьи срока в своём прежнем, подчеркнём, едином виде[30]. Разве это не признак провала прежнего ошибочного замысла проведения единого государственного экзамена?

А кто, кроме чиновников, сейчас считает, что новый вариант проведения ЕГЭ, ориентированного преимущественно на приём в вузы, лучше? Никто. Сама идея отбирать абитуриентов одинаковыми «материалами» в разные вузы – такая же ошибочная и вредная, какой была и идея единого экзамена. Если вузы разные, и туда идут студенты с разной подготовкой, то согласно с требованиями постулата соответствия теории педагогических измерений, задания должны быть разные по уровню трудности, такие, которые позволяют, соответственно, каждому вузу точнее отобрать искомый контингент. При проверке всех одним и тем же набором «материалов» точность оценок резко ухудшается. Это особенно сказывается на правой стороне распределения исходных баллов, у наиболее подготовленных испытуемых, что видно на приводимых далее гистограммах.

Коррупция не уменьшилась, а увеличилась, теперь уже вокруг ЕГЭ. И это уже не мнение, а профессионально установленный точный факт[31]. А значит, это, одновременно, и факт провала одной из главных целей введения ЕГЭ – снижения коррупции. В министерстве образования и науки все годы т.н. «эксперимента по ЕГЭ» убаюкивали себя тем, что этот факт их не касается, что борьба с коррупцией вокруг ЕГЭ – дело других ведомств. Никто в Правительстве РФ их не поправил. Хотя без шума меняли, время от времени. Именно такая негласная позиция и привела к всплеску коррупции.

Факты непригодности «материалов» ЕГЭ

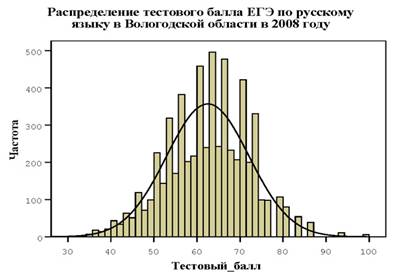

На рис. 1 представлено трансформированное распределение т.н. «тестовых» баллов ЕГЭ по русскому языку, полученное благодаря запросу комиссии при Совете Федерации. Реальное распределение так и не удалось получить даже этому представительному органу.

Рис. 1

Представленное распределение похоже на гребёнку, вызванную, скорее всего, искусственным нарушением ранее выбранных интервалов построения гистограммы. Что само по себе, при отсутствии реальных результатов, может свидетельствовать о стремлении исполнителей скрыть настоящую картину - непригодность исходных «материалов» и полученных по ним результатов ЕГЭ. Реальное распределение было бы много полезнее для улучшения дел. Но и это слышать не хотели.

Здесь неработающей оказалась правая часть, связанная с использованием части «С». Разве это не признак провала некачественного контрольного «материала» и самого ЕГЭ? Справа на рис. 1 два всплеска, в районе девяносто четырёх и ста баллов, которые могут интерпретироваться как коррупционные, в принципе не вытекающие из логики распределения результатов. А это тоже вполне статистически доказательный признак провала.

Другой факт искусственно сжатого (справа) трансформированного распределения результатов по русскому языку, но теперь уже во всероссийском масштабе представлен на рис. 2[32]. Этот т.н. «тест» сделан избыточно лёгким. Таким смещённым, асимметричным тест не позволяется делать даже студентам. По приведённым данным, только 3,3 % испытуемых не смогли преодолеть минимально определённый в кабинетах Рособрнадзора порог, который устанавливали, в нарушение существующих на Западе этических норм, не до, а после проведения экзамена.

Рис. 2. Распределение участников экзамена по полученным тестовым баллам в

Слева на рис. 2 возник своеобразный «проходной двор» – почти все испытуемые (96,7%) успешно сдали требования единого государственного экзамена к владению русским языком. Это очевидный артефакт, вызванный завышенной лёгкостью, высокой вероятностью угадывания правильных ответов в первой части и массовыми нарушениями процесса проведения государственного экзамена.

Реально дети говорят на русском языке, а особенно пишут, не лучше, а хуже, чем это было до введения ЕГЭ. Похоже, что именно про такой случай разработки контрольных «материалов» прочувственно говорила пожилая учительница из Самарской области, позвонившая в Общественную палату РФ: «Я хотела бы передать благодарность тому, кто придумал ЕГЭ. ЕГЭ построен таким образом, что почти невозможно сдать на двойку!» (документированная запись № 2128, Самарская область)[33]. Разве эта благодарность опытного педагога, довольного таким удачным исходом государственного экзамена – не убедительный пример некачественности используемого тем же государством контрольного «материала» ЕГЭ?

Справа на рис. 2 распределение сжато так, что коррупционные всплески исчезли совсем, появилось немало отличников. Таким ЕГЭ тоже оказались довольными большинство испытуемых, часть родителей. Довольны и чиновники Министерства образования, создавшие видимость «Большого скачка» в работе Министерства, хотя на самом деле, по общему мнению, образование в стране деградирует.

Напрашиваются вопросы. Сколько времени всё это шоу будет ещё продолжаться? Так же «вечно», как и ЕГЭ? Тогда надо быть готовым к тому, что ЕГЭ, независимо от желания толкачей этого экзамена, закончится очень скоро! Похожая на ЕГЭ система была в Древнем Китае, но она рухнула под напором коррупции[34].

Шансы закончить среднюю школу с документом об успешном окончании школы даёт большинству экзаменуемых и т.н. «КИМ» по математике (рис. 3). Но здесь распределение исходных баллов оказалось асимметричным в противоположную сторону.

Распределение в левой части шкалы исходных результатов по математике похоже на нормальное, но это характерно лишь для слабой части испытуемых, с модальными значениями 8 и 9 баллов, близких к минимально «проходным». Иначе говоря, массовое математическое образование у нас достигло минимального одобренного порога.

|

Рис. 3 . Распределение исходных результатов по ЕГЭ (математика - 2010).

Из-за стремления разработчиков этого «материала» выполнить министерские установки «единого» экзамена, точность оценок у хорошо подготовленных выпускников школ на российском государственном экзамене оказалась недопустимо низкой. В зоне чрезмерно высокого риска получения ошибочных оценок оказались самые подготовленные выпускники школ. Разве это не метрический аргумент провала ЕГЭ?

При сравнении результатов получается, что математику в российских школах дети знают много хуже, чем русский язык. Именно на такой вывод наталкивает единственный, в истории проведения ЕГЭ, случай публикации распределения исходных результатов ЕГЭ по математике в

В классической (статистической) теории педагогических измерений уже давно сложилась традиция считать результаты тестов с асимметричным распределением баллов как относительно невалидные по двум возможным причинам: либо трудность большинства заданий не соответствует уровню подготовленности большинства испытуемых, либо, наоборот, уровень подготовленности большинства испытуемых не соответствует уровню трудности большинства заданий. И то, и другое снижает качество измерений и практическую полезность.

Посмотрим ещё на один факт[36], представленный в табл. 1.

Решаемость заданий ЕГЭ по физике в 2007 году, по вариантам (1 волна).

Задания групп «A», «B»

Табл.1

| Номер варианта |

A1 |

A2 |

A3 |

A4 |

A5 |

A6 |

A7 |

| 1 |

79,71% |

60,87% |

43,48% |

55,07% |

72,46% |

81,16% |

40,58% |

| 2 |

52,17% |

53,62% |

60,87% |

62,32% |

65,22% |

78,26% |

30,43% |

| 3 |

70,67% |

58,67% |

49,33% |

50,67% |

69,33% |

68,00% |

32,00% |

| 4 |

72,22% |

52,78% |

48,61% |

66,67% |

66,67% |

37,50% |

58,33% |

| 5 |

45,83% |

47,22% |

58,33% |

40,28% |

54,17% |

38,89% |

83,33% |

| 6 |

55,41% |

20,27% |

55,41% |

89,19% |

83,78% |

27,03% |

66,22% |

| 7 |

50,00% |

25,00% |

56,94% |

84,72% |

86,11% |

69,44% |

76,39% |

| 8 |

76,81% |

56,52% |

47,83% |

50,72% |

69,57% |

78,26% |

34,78% |

| 9 |

58,57% |

47,14% |

38,57% |

72,86% |

68,57% |

71,43% |

41,43% |

| 10 |

77,46% |

50,70% |

56,34% |

67,61% |

64,79% |

73,24% |

43,66% |

| 11 |

72,06% |

66,18% |

64,71% |

94,12% |

82,35% |

48,53% |

75,00% |

| 12 |

54,55% |

36,36% |

57,58% |

86,36% |

59,09% |

34,85% |

71,21% |

| 13 |

54,69% |

32,81% |

65,63% |

50,00% |

84,38% |

54,69% |

60,94% |

| 14 |

50,00% |

51,52% |

71,21% |

89,39% |

83,33% |

56,06% |

86,36% |

| 15 |

В69,49% |

22,03% |

64,41% |

81,36% |

69,49% |

32,20% |

74,58% |

| Среднее |

62,64% |

45,66% |

55,69% |

69,21% |

71,91% |

56,85% |

58,01% |

Продолжение таблицы 1

| Номер варианта |

A8 |

A9 |

A10 |

A11 |

A12 |

A13 |

A14 |

A15 |

| 1 |

23,19% |

31,88% |

34,78% |

60,87% |

50,72% |

56,52% |

34,78% |

44,93% |

| 2 |

24,64% |

37,68% |

39,13% |

59,42% |

59,42% |

63,77% |

50,72% |

17,39% |

| 3 |

42,67% |

36,00% |

37,33% |

45,33% |

56,00% |

69,33% |

48,00% |

14,67% |

| 4 |

36,11% |

16,67% |

34,72% |

41,67% |

63,89% |

79,17% |

47,22% |

19,44% |

| 5 |

45,83% |

11,11% |

31,94% |

48,61% |

37,50% |

58,33% |

70,83% |

40,28% |

| 6 |

32,43% |

54,05% |

56,76% |

18,92% |

29,73% |

64,86% |

41,89% |

18,92% |

| 7 |

62,50% |

12,50% |

43,06% |

50,00% |

38,89% |

63,89% |

29,17% |

27,78% |

| 8 |

33,33% |

36,23% |

56,52% |

52,17% |

63,77% |

62,32% |

33,33% |

15,94% |

| 9 |

45,71% |

35,71% |

57,14% |

50,00% |

62,86% |

70,00% |

52,86% |

57,14% |

| 10 |

43,66% |

47,89% |

46,48% |

69,01% |

61,97% |

66,20% |

32,39% |

23,94% |

| 11 |

63,24% |

22,06% |

51,47% |

29,41% |

42,65% |

83,82% |

63,24% |

29,41% |

| 12 |

51,52% |

13,64% |

65,15% |

48,48% |

78,79% |

68,18% |

42,42% |

19,70% |

| 13 |

50,00% |

57,81% |

43,75% |

57,81% |

26,56% |

62,50% |

34,38% |

32,81% |

| 14 |

36,36% |

25,76% |

53,03% |

53,03% |

42,42% |

71,21% |

56,06% |

43,94% |

| 15 |

62,71% |

15,25% |

55,93% |

57,63% |

28,81% |

86,44% |

55,93% |

37,29% |

| Среднее |

43,34% |

30,41% |

46,91% |

49,23% |

49,81% |

68,24% |

46,14% |

29,34% |

Анализ таблицы позволяет доказательно утверждать, что в этом материале, созданном для проверки знаний по физике, нет ничего похожего на тест как систему заданий возрастающей трудности, имеющих параллельные варианты. Они совсем не параллельны по уровню трудности. В таблице видна недопустимо большая вариация заданий по трудности, между вариантами одного и того же номера контрольного «материала». Из-за чего ЕГЭ превратился не в средство педагогического измерения, а в форму проведения лотереи.

Уже по одной этой причине единый экзамен, как государственный, не имеет права на применение, поскольку этим некачественным экзаменом нарушаются права испытуемых и их родителей на объективную и справедливую оценку уровня подготовленности. Баллы испытуемых сильно зависят от попавшегося варианта экзамена. И это ещё одно доказательство некачественности контрольных материалов государственных экзаменов. Разве и это не провал ЕГЭ?

Три вопроса

В связи с представленными здесь фактами могут возникнуть три вопроса и три вероятных ответа.

Первый вопрос: Могли бы данные 2011 года стать свободными от недостатков, или стать лучше ранее полученных результатов, представленных в этой статье?

Ответ прост: из-за режима секретности результатов ЕГЭ науке это неизвестно. Надо открыть исходные распределения прошлых лет и новые данные. Эти данные не конфиденциальны по смыслу, но превратились в конфиденциальные по антиобразовательному замыслу и исполнению. Только после этого можно узнать – новые контрольные «материалы» стали лучше или, скорее всего, ещё хуже? Неужели гражданам страны и Правительству РФ неинтересно знать ответ на такой вопрос?

Второй вопрос: а сколько нужно ещё привести фактов некачественности контрольных материалов единых государственных экзаменов, чтобы Министерство образования и науки, а также Правительство РФ приняли, наконец, решение о прекращении проведения единых государственных экзаменов для выпускников школ и абитуриентов различных вузов?

До выборов 2012 года мы вряд ли получим ответ и на этот вопрос. Пока только видно, что власть, похоже, стремится сохранить «навечно» асоциальный вариант экзамена и хочет засекречивать некачественные материалы далее. А после 2012 года ответ будет зависеть от результатов выборов и от исхода возможных послевыборных событий.

Третий вопрос: а что, если всё продолжится так же, как сейчас?

Тогда можно предположить, что государственные экзамены развалятся, и окончательно. Никакой бюрократический режим их проведения и никакие контрольные «материалы» их не спасут. А образование в стране начнёт деградировать ещё сильнее. Россия, с её природными ресурсами и огромными территориями, останется без качественно образованного населения. Как писал О. Шпенглер, сегодняшняя мощь "наций" есть следствие всего-навсего прошлой школьной политики. Пусть каждый читатель решит для себя – правильно ли будет сказать, что возможная завтрашняя немощь страны станет результатом сегодняшней образовательной политики?

Спорное решение Государственной Думы

Развитию педагогических измерений в России мешают контрольные материалы для проведения государственных экзаменов. Теперь они станут мешать ещё больше. Наметившаяся тенденция законодательного усиления ответственности за нарушения режима проведения единого государственного экзамена – это ещё один шаг к сторону разрушения образования в стране.

Госдума приняла законопроект, в котором написано, что контрольные измерительные материалы (КИМы) ЕГЭ признаются конфиденциальной информацией[37]. Это было сделано, опять-таки, казалось бы, из благих побуждений – сохранить упомянутые материалы от несанкционированного доступа до начала экзаменов, обеспечивая, тем самым, равный доступ граждан к высшему образованию.

Факты нарушения сохранности используемых в ЕГЭ заданий возникают ежегодно, во многих местах и в массовом порядке, что, очевидно, указывает на несовершенство идейных основ, проектной схемы, процедуры и самой организации этого экзамена. Достаточно привести один самый массовый пример. В 2011 году, во время ЕГЭ по математике многие выпускники получали ответы на мобильные телефоны из популярной социальной сети «В контакте». В специально созданной в этой сети группе, которая существует уже несколько лет, и в которую вступили около 300 тысяч человек, размещались варианты ответов ЕГЭ, причем информацию предлагали купить за деньги[38].

По замыслу депутатов Госдумы, придание материалам юридического статуса конфиденциальности позволит удержать ЕГЭ от дальнейшего интенсивного саморазрушения. Но это очень спорный, если не ошибочный, замысел. Он укладывается в логику бюрократического режима проверки знаний, но противоречит логике научной организации системы педагогического контроля, с педагогическими принципами этой системы[39].

Само слово "конфиденциальный" происходит от латинского confidentia – доверие и в современном русском языке означает "доверительный, не подлежащий огласке, тайный, секретный". Получается, с точки зрения языка, что понятия «конфиденциальная информация», «тайна» и «секрет» могут восприниматься как равнозначные. Однако в юридической литературе эти понятия не признаются равнозначными.

Согласно п. 2 ст. 10 ФЗ "Об информации ...", документированная информация с ограниченным доступом по условиям её правового режима подразделяется на информацию, отнесенную к государственной тайне и на конфиденциальную информацию. Отсюда можно вывести, что КИМы ЕГЭ законом «Об информации…» не могут быть отнесены ни к государственным секретам, ни к государственной тайне. Кроме того, понятие «тайна» означает, как видно из п.2 упомянутого Закона, ещё и наличие правового режима сохранности информации. Судя по всему, конфиденциальную информацию о некачественных материалах ЕГЭ, не имеющих никакого юридического статуса, в Госдуме не сопроводили наличием такого правового режима. Да и как это сделать?

К тому же применение данной юридической новации в практике усложняется тем, что в настоящее время нет чёткой и единой классификации видов конфиденциальной информации. Действующими нормативными актами установлено свыше 30 разновидностей конфиденциальной информации. Какую разновидность конфиденциальности педагогических заданий держат в уме думские законодатели, науке также не известно.

И уже совсем не может быть юридического термина «контрольные измерительные материалы», которым сегодня оперирует послушное правительству большинство Госдумы. Инициаторам конфиденциальности и каждому голосовавшему за предложение Правительства полезно задать один-единственный вопрос: где они видели измерительные свойства пресловутых «материалов»?

Важно, к тому же, понять, что в решении Госдумы речь идёт, по сути, не об информации, вполне юридическом термине, а о педагогических «материалах» имеющих неконкретный, скорее мифологический смысл[40], относительно которых режим конфиденциальности и правового режима если и возможен, то в гротескном или абсурдном виде. Хотя бы задумались над тем, что педагогические задания никто, нигде и никогда в мире законодательно не засекречивал.

В словосочетании «контрольно-измерительные материалы» слово «измерительные» не имеет никакого реального смысла. «Материалы» также нигде и никогда не были средством измерения. Это неумный вымысел российских министерских умельцев, размноженный услужливой пропагандой.

В других странах к секретной информации, ограниченной коротким временем, относят не сами задания, а только коды ответов на варианты используемых заданий. Так это установлено, например, законодательным органом Казахстана. И это правильно.

В большинстве демократических стран тестированием занимается не государство, а специальные независимые центры, которые, по уставу, не имеют права засекречивать задания и иные «материалы», если последние там вдруг обнаружатся. Напротив, они обязаны заблаговременно знакомить испытуемых со всеми типами заданий, которые потенциально могут быть (а могут и не быть) использованы в процессе конкретного предстоящего контроля. Здесь возникает вопрос стратифицированной выборки заданий теста из генеральной совокупности заданий.

Если какой-то абитуриент в процессе специальной подготовки сумеет найти правильные ответы на большинство заданий по интересующему предмету, имеющихся в базе, то это может означать только одно – такой испытуемый имеет высокий уровень подготовленности. И ему нечего бояться и ловчить. Он готов к тестированию или экзамену. Легко видеть, что открытость заданий в таком варианте даёт положительные образовательные результаты. Принятая же Госдумой РФ конфиденциальность контрольных «материалов» ведёт к отрицательным результатам.

В разных странах мира не было случаев запрета на ознакомление учащихся с примерами заданий, содержащихся в базе данных. Эти задания, наоборот, активно используются для тренировочного контроля уровня подготовленности испытуемых в процессе самообразования. Этим затрагивается другой ключевой вопрос эффективной образовательной деятельности – использование обучающего потенциала заданий в тестовой форме для обучения. В этом аспекте Россия слишком отстала от Запада и Востока. Очевидно, мы имеем дело с проявлением ретроградной позицией Министерства образования и науки.

Вопрос, следовательно, стоит не о запрете на ознакомление учащихся с заданиями вообще, а об ограничении доступа к ознакомлению с ответами на конкретные варианты заданий, отобранные специальными методами педагогических измерений для применения только во время проведения контроля.

Например, настоящее тестирование абитуриентов и школьников проводится в течение примерно сорока минут. За это время никто из испытуемых не успеет ни скопировать, ни передать тексты всех доставшихся лично ему вариантов заданий. И получить затем решённые другими лицами задания; да и на решение трудных заданий, и на проверку ответов тоже нужно немало времени. И потом ещё надо будет вписать правильно полученные извне ответы в специальный бланк. Гораздо эффективнее в таких случаях тактика использования отведённого времени на быстрое решение тех заданий, которые испытуемый может решить самостоятельно.

Разгадку смысла думского решения о признании КИМов ЕГЭ «конфиденциальной» информацией можно найти в работе А.В.Ефремова «Бюрократия и бюрократизм». Там говорится об использовании общих приёмов искусственной служебной конфиденциальности, помогающей бюрократии уйти от общественного контроля, закрытия доступа к информации, о действиях аппарата, недопущения действительной гласности[41] и много чего ещё интересного. К ЕГЭ это относится на все сто процентов.

Своим сомнительным решением Госдума фактически вводит запрет на ознакомление педагогов и общественности с некачественными, надо подчеркнуть, контрольными заданиями и на реальные распределения результатов ЕГЭ. Между тем, в любой демократически развитой стране граждане имеют право знакомиться с заданиями, которые могут быть использованы в процессе проверки знаний. Из обозримой совокупности каждому испытуемому достанется выборочная совокупность из вариантов таких заданий.

В разумно управляемой стране научные работники обязаны знать реальные распределения результатов и объективную статистику, чтобы подсказать властям, где и что можно улучшать. Особенно по областям и территориям России. Но торжествующее ныне маргинальное бюрократическое мышление не позволяет говорить правду и что-то улучшать в этой сфере. А потому засекречивание «материалов» год от году крепчает.

Любопытна ещё одна сторона признания конфиденциальными контрольных материалов государственного экзамена. Своим решением, вольно или невольно, Госдума РФ вводит, по существу, запрет на научную критику этих самых «материалов». Потому что невозможно или очень рискованно аргументировано критиковать конфиденциальную информацию бюрократического режима проверки знаний учащихся.

И не появятся ли, вслед за решением о конфиденциальности, желание и возможность привлечь к ответственности за критику тех, кто выступает против применения некачественных, но теперь уже «конфиденциальных контрольных материалов» российского государственного экзамена? По сути, заготовлена юридическая дубинка, которая может соблазнить неумные головы использовать её против критиков ошибочных и вредных для страны решений. Однако пришла пора образумиться и остановиться, не множить далее число глупостей, которых и так накопилось много в системе образования.

Наконец, в свете изложенного, не совсем понятно – каким образом законодательная инициатива Правительства РФ о введении конфиденциальности «материалов ЕГЭ», одобренная Госдумой, сочетается с заявлением главы того же самого Правительства В.В.Путина[42] о его поддержке справедливой критики ЕГЭ[43]? Конструктивная критика невозможна без открытых публикаций «материалов» ЕГЭ? Нет ли здесь противоречия? Если есть, то эти противоречия хорошо бы устранить самому Правительству РФ.

Ранний этап развития педагогических измерений

Начало развития теории и практики психологических и педагогических измерений можно проследить, начиная с работ Ф.Гальтона, Э.Торндайка, А.Бине и других зарубежных авторов, работавших в конце ХIХ-го – начале ХХ-го веков[44]. Практика измерений существовала тогда в форме применения вопросов и заданий, с последующим суммированием баллов испытуемых за каждое задание. Эти баллы нередко назвались тестовыми, и они воспринимались тогда как результаты педагогических измерений. Такая практика перевода качественных явлений в количественные оценочные показатели имела глубокие исторические корни[45].

Позже, во второй половине ХХ-го века, возникла культура педагогических измерений, включающая в себя, как тогда писали, «теорию тестов», культуру формулирования заданий[46], а затем шкалирования исходных баллов испытуемых и уровня трудности заданий. А это полностью изменило прежние представления о сущности педагогических измерений. Теперь измерения понимаются как объединённый процесс разработки теорий, методик тестирования испытуемых и компьютерного шкалирования получаемых результатов.

К счастью для педагогических измерений, необходимость соотносить теоретические соображения с проверкой реальных результатов была осознана довольно рано. В начале ХХ века А. Бине и Т. Симон проводили эмпирическую проверку каждого задания, которое предполагалось включить в тест. Для оценки пригодности заданий для измерения уровня развития детей разного возраста авторы использовали два основных критерия: 1) меру трудности заданий, которую они определяли по доле правильных ответов в группах детей разного возраста[47] и 2) информацию о степени совпадения результатов теста с мнением преподавателей. А. Бине и Т. Симону принадлежит также важная идея расположения заданий теста в зависимости от возрастания меры их трудности[48]. Этими критериями проверки пригодности заданий для разработки теста как системы заданий возрастающей трудности тестологи пользуются до сего дня.

В России, после революционных потрясений начала ХХ-го века, возрождавшееся народное образование открылось практически всем известным тогда в мире педагогическим новациям. Появились комплексный и исследовательский методы обучения, Дальтон-план, метод проектов, система полного усвоения знаний, коллективного обучения и многое другое. Среди этих новаций были попытки создания теории и методики педагогических измерений. Период развития был, однако, недолог. В

Роль авторитаризма и эгалитаризма

В начале 30-х годов в СССР начал усиливаться авторитаризм, вначале в политике, а затем и в сфере образования. Он препятствовал развитию объективных методов контроля знаний, ибо в нём усматривалась угроза существованию авторитарной системы, с её тщательно культивируемым отрицательным подбором кадров из близкого окружения, из-за чего каждое последующее поколение управленческих кадров оказывается хуже предыдущего. Решающим критерием подбора кадров становятся не конкурс способностей и уровня образованности, а исполнительность в выполнении приказов вышестоящих лиц.

Одновременно с авторитаризмом в те же годы начал распространяться и эгалитаризм, который проявлялся в виде идеи всеобщего равенства и искусственного выравнивания, даже там, где неравенство неизбежно. Например, неравенство способностей разных лиц к различным видам деятельности. Эгалитаризм проявлялся в виде псевдонаучных суждений о равенстве способностей, одинаковой обучаемости, о возможности каждым человеком овладеть любой профессией, а также в виде одинаковой зарплаты преподавателям, независимо от фактических знаний тех учащихся, которых они учат. Эгалитаризм проповедует принцип: "За равный труд - равную зарплату". Главный упор делается на равном труде, с неизбежным отсюда нормированием, как главным средством повышения общей производительности труда.

Под влиянием авторитарных и эгалитарных социально-психологических и политических установок в педагогической среде актуализировались афоризмы типа "Нет плохих учеников, есть плохие учителя", "Незаменимых людей нет" и т.п. В обществе, устроенном по эгалитарному принципу, все люди рассматриваются как взаимозаменяемые "винтики" одной огромной государственной машины, управляемой незаменимым лидером. Такие установки уже нанесли стране неисчислимый вред.

Воцарившаяся после запрета ситуация отрицательного отношения к тестам не давала кому-либо практической возможности публиковать что-либо в их защиту. И эта ситуация продолжалась в течение длительного времени. Авторитарный стиль легко утверждается, но трудно и долго искореняется.

Сейчас в России вместо тестов используют контрольные «материалы» государственного экзамена. Вместе с тем, растёт и число тех, кто путает тесты с контрольными материалами ЕГЭ, кто рассматривает тест как элементарный перевод с английского языка слов «проба, испытание, проверка». Без указания на существенные признаки, выводящие тест за пределы элементарного перевода, как того требует научная логика.

Как показывает опыт издания российского научно-методического журнала «Педагогические Измерения» к настоящему времени в стране оказалось слишком мало авторов, способных писать качественные тексты по проблеме педагогических измерений.

Период активного развития педагогических измерений

На Западе периодом активного развития педагогических измерений стало время между 1950 годом и серединой 1980-х годов. Этот период отмечен научно-методическими достижениями D.C. Adkins[50], N.E. Glonlund[51], C.M. Lindvall & A.J. Nitko[52], W.A. Mehrens & Lehmann[53], A.J.Nitko[54], G. Sax[55], A.G.Wesman[56] и мн. др.

В девяностые годы ХХ-го века в педагогических измерениях США наметился явный успех, связанный с появлением работ R.E. Bennet & W. Ward[57], S.B. Carlson[58], N. Frederiksen[59], E.E. Freeman[60], , R.J. Mislevy[61], S.J. Osterlind[62], W. Wiersma & S.G. Jurs [63] и мн. др. Близко к созданию теории педагогических измерений подошёл в США R.Ebel[64].

В СССР и России проблемой развития педагогических измерений занимался, среди других, автор этой статьи. За период с начала 80-х годов ХХ века до начала второго десятилетия ХХI-го века удалось подготовить и опубликовать десятки работы по ключевым вопросам развития педагогических измерений. Почти все они представлены на сайте автора[65]. Ранее этого периода были опубликованы труды по психологическим[66] и социологическим[67] измерениям.

В качестве основы теории педагогических измерений была разработана система понятий педагогических измерений, принципы разработки формы[68] и содержания тестовых заданий[69], концепция пяти этапов тестового педагогического процесса [70]. В этой концепции бюрократическому режиму проведения контроля посредством контрольных материалов места нет.

Уровневое функционирование педагогических измерений

Первый, самый распространённый уровень функционирования педагогических измерений связан с практической деятельностью, похожей на тестирование. Но только внешне. Как, например, в контрольных материалах российского государственного экзамена есть задания, внешне похожие на тестовые, но их действительные свойства далеко не тестовые. Засекречивание помогает сохранить этот дефект режимного метода.

Действительно, получаемые в ЕГЭ баллы слишком часто ошибочно называются тестовыми, хотя сущностных признаков теста там нет. Именно в таких случаях на Западе говорят, что тестовые баллы без процесса специального шкалирования ещё не образуют измерений[71]. А иные баллы, полученные посредством контрольных материалов, вне культуры метрического процесса, вообще далеки от педагогических измерений. Именно этот случай подпадает под известное определение классика: если бы внешняя видимость вещей и их суть совпадали бы, то всякая наука была бы излишней.

Первый уровень существует стихийно, без видимой организации. Носители такого низкого уровня функционирования педагогических измерений редко контактируют между собой, поскольку нет реальной содержательной основы для их совместной деятельности. Но их иногда собирали для осуждения неугодных лиц. Тогда этот уровень принимал форму антинаучной, по сути, деятельности.

Например, при Министерстве образования в 1990-х годах был организован т.н. «Научный совет по тестированию». Ничего научного после себя это совет не оставил, но ущерб педагогическим измерениям как науке он нанёс немалый. Главное – он «научно» одобрил проведение ЕГЭ. Недостаточно качественно проводившееся централизованное тестирование и массовое применение тестоподобных форм в большинстве государственных и вузовских центрах тестирования также можно отнести к нетеоретическим формам начальной тестовой и тестоподобной деятельности.

Первый уровень преодолим при наличии научной литературы и поощрения открытости результатов, обязательной отчётности, понимания позитивной роли научной критики полученных результатов и отстранения бюрократии от непосредственного управления проблемами, принципиально требующих других, общественно-профессиональных форм управления. При государственном управлении сферой проверки знаний, отгороженной от общественной критики режимом засекречивания педагогических заданий и обобщённых статистических распределений, антипедагогические искривления, ложь, обман и провалы неизбежны.

Второй уровень функционирования педагогических измерений связан с практикой тестирования, опирающейся на отдельные элементы теории педагогических элементов. Это уровень соединения теории с практикой, постепенного усиления практики теорией, развития методики педагогических измерений. Он характерен для использования в развивающихся педагогических учреждениях и для улучшающегося образования в целом. И неизбежен в силу того, что нельзя сразу перейти с низшего уровня на высший уровень. Этот уровень открывает возможности теоретизации, позволяет развивать личность и систему образования на основе развивающейся теории, что сказывается благотворно на соединении интересов личности, общества и государства.

Третий уровень включает активное развитие теории педагогических измерений и эффективную практическую деятельность по разработке научно обоснованных методов измерения (методологии). На этом уровне ценится теоретическое и методологическое знание, издаётся литература, выпускаются специализированные научные журналы, разрабатываются математико-статистические программы разработки тестов и шкалирования данных тестирования, ведутся научные дискуссии. Качественно проводимое тестирование также относится к практической стороне третьего уровня педагогических измерений.

Предмет третьего уровня – разработка теории педагогических измерений. Критикой теории и конструктивным преобразованием практики призвана заниматься методология педагогических измерений. Третий уровень противостоит псевдоизмерениям. Он предполагает открытую публикацию всех статистических результатов, представляющих интерес для тестологов, снятие всех незаконных запретов на публикацию реальных тестовых результатов, без указания данных об испытуемых. Особенно необходимы статистика параллельности заданий, меры общей и дифференцированной надёжности результатов, доказательства пригодности используемых заданий и полученных данных для различных целей. К сожалению, этой статистики тоже нет. Бюрократия своих привычек не меняет.

Определения исходных понятий теории педагогических измерений

Ранее педагогическое измерение было определено как процесс определения меры интересующего свойства личности испытуемых на латентной интервальной шкале посредством качественного теста, состоящего из системы заданий равномерно возрастающей трудности, позволяющего получать педагогически целесообразные результаты, отвечающие критериям надёжности, валидности, объективности и эффективности. В этом определении курсивом выделены основные термины, позволяющие отграничить признаки педагогических измерений, от прочих методов, научных, псевдонаучных и ненаучных[72].

На языке философии педагогические измерения можно рассматривать как специфическую форму научно-практической педагогической деятельности, имеющей своим предметом получение численных значений уровня образовательной подготовленности личности по интересующей учебной дисциплине или интересующего педагога свойству. Выделение курсивом слова «педагогической» имеет актуальный для России смысл, указывающий на принадлежность этой проблемы не образовательной бюрократии, как сейчас, а педагогической науке.

Любопытно схематическое представление самого простого, классического определения измерения, данного более чем полвека назад С.С. Стивенсом[73].

Здесь оно сопровождается примером создания шкалы отношения граждан к иммигрантам[74]. Согласие респондента с содержанием каждого следующего вопроса указывает на более высокую меру его толерантного (невраждебного) отношения к иммигрантам. Враждебное отношение и готовность использовать насилие по отношению к «инородцам» измеряется шкалой национализма.

Рис. 4

Цель педагогического измерения – определить количество интересующего латентного свойства личности (меру интересующего признака), присущего данному испытуемому.

Результат педагогического измерения - латентная числовая величина, позволяющая установить числовое соотношение между испытуемыми по изучаемому свойству. Аналогично устанавливается числовое соотношение между используемыми в тесте заданиями, по изучаемым свойствам. Измеряемую величину образуют интересующее свойство и результаты теста, варьирующие, по уровню проявления, у множества испытуемых. Отсутствие вариации результатов и высокая погрешность являются существенными признаками некачественности педагогического измерения.

Главный метод педагогических измерений – педагогический тест, представляющий собой систему вариативных заданий равномерно возрастающей трудности, позволяющей качественно оценить структуру и эффективно измерить уровень подготовленности испытуемых по одной или нескольким учебным дисциплинам. Смысл словосочетания «система вариативных заданий» означает, что каждое задание теста имеет свои параллельные варианты.

В педагогических измерениях в обязательном порядке используются математико-статистические методы шкалирования получаемых результатов испытуемых и свойств заданий. В итоге получается шкала, имеющая нулевое начало, единицу измерения, достаточную протяженность. Это – свойства шкалы.

Модель измерения определяется как структурное построение, позволяющее соединить латентную переменную величину с наблюдаемыми значениями этой величины[75].

Педагогической шкалой называется упорядоченная совокупность значений испытуемых на латентной переменной величине, служащей основой для измерения данной величины. Идеальный образ шкалы педагогического измерения - линейка с нулевой отметкой посредине, с равными интервалами значений, с положительными значениям справа, и отрицательными значениями – слева.

Поскольку отрицательные значения баллов испытуемых критически воспринимаются в образовательной среде, часто используется методы трансформация данных, такие, чтобы баллы всех испытуемых были представлены на шкале положительных значений. Наиболее часто применяемая трансформационная шкала исходных баллов испытуемых – так называемая T-шкала.

Шкалирование определяется как та часть процесса измерения, в котором исходные значения тестовых баллов испытуемых и меры трудности заданий переводятся в стандартные значения с общей единицей измерения, с удобными, для интерпретации, значениями средней арифметической и вариации данных. В Rasch Measurement результатом шкалирования является расположение объектов на шкале логитов.

Другие важные определения теории педагогических измерений сформулированы в работах, представленных в журнале «Педагогические Измерения» и на сайте автора[76].

Необходимость методологии педагогических измерений

Ранее методология педагогических измерений была определена как учение об основных положениях, формах, методах, принципах научного исследования и организации эффективной практики в разработке показателей качества подготовленности учащихся и показателей педагогической деятельности[77].

Одна из важных задач методологии – правильное определение целей развития педагогических измерений. Недостаточное внимание к вопросам методологического анализа целей ЕГЭ и контрольных материалов привело к печальным результатам[78].

Второй важный вопрос методологии – это критика и развитие теории. В российской и мировой литературе нет достаточной ясности относительно теоретической основы педагогических измерений. На Западе больше развиты статистические и математические теории педагогических измерений, в то время как собственно педагогическую теорию измерений там пока не удалось создать. В первую очередь это касается трёх главных вопросов теории: вопросов композиции формы и содержания педагогических тестов, а также вопросов состояния понятийного аппарата педагогических измерений.

Раньше в качестве такой основы ошибочно рассматривались статистические теории[79]. Затем – математическая теория, Item Response Theory (IRT). В России IRT иногда провозглашалась как «единственная» и «современная» теоретическая основа педагогических измерений. Но это ошибочно. Все существующие сейчас теории применимы не только к педагогическим, но и к психологическим и социологическим измерениям. Хотя эти теории широко применяются для проведения педагогических измерений, в них нет собственно педагогического содержания, как нет методов и принципов решения содержательных педагогических проблем.

К тому же это теории формальные, не имеющие, по существу, педагогического содержания. В то время как именно содержание теории указывает на её предметную отнесённость. А это означает, что эти теории в значительной мере являются общими, или общенаучными, не нагруженными содержанием собственно педагогики[80].

Вопрос о необходимости создания собственно педагогической теории измерений был поставлен в первом номере российского научно-методического журнала «Педагогические Измерения»[81]. В той статье отмечалось, что основное содержание теории педагогических измерений могли бы составить собственный язык (тезаурус) теории, принципы формулирования заданий, а также содержание теста, тестовых заданий и заданий в тестовой форме.

Внимание читателей обращалось на такие ключевые вопросы теории педагогических измерений, как система понятий теории, вопросы формы и содержания тестовых заданий, возможности обучающего потенциала заданий в тестовой форме, подходов к педагогической интерпретации результатов измерения – содержательно-ориентированной, критериально ориентированной или нормативно-ориентированной.

Основные направления развития педагогических измерений

Первое и самое актуальное направление развития – это полное, по возможности, отграничение (демаркация) педагогических измерений от контрольных материалов государственных экзаменов и от иных псевдометрических форм и методов, распространяемых сейчас в России под видом средств педагогических измерений. Необходимость демаркации вызвана расширяющейся практикой смешения научных форм и содержания педагогических измерений с ненаучным и антинаучными элементами проведения в России ЕГЭ.

Демаркации педагогических измерений было посвящено специальное исследование автора, в котором было выделено 13 критериев, позволяющих отделить педагогические измерения от прочих методов[82]. Основные критерии, сформулированные в том исследовании - это организация в стране процесса педагогических измерений; развитие культуры научного обоснования тестов; обязательность предварительной эмпирической апробации всех заданий, включаемых в методы измерения, открытость результатов измерений для научного анализа и критики, организация теоретических исследований, технологичность всех этапов, разработка стандартов метрической деятельности, пакетов для математико-статистической обработки данных, технических и этических стандартов на разработку и применение тестов и др.[83]

Второе направление развития педагогических измерений – это совершенствование форм тестовых и нетестовых педагогических заданий. Сложность такой работы вытекает из противоречия, реально существующего между теоретическим и практическим мышлением. Большинству чиновников и практиков тестового процесса форма заданий считается знакомой и вполне понятной, а потому они не видят здесь никаких проблем. Их логика проста: в любом деле, в первую очередь, важна не форма, а важно содержание. Однако в педагогических измерениях форма играет очень важную роль, как способ связи и упорядочения элементов содержания в общей композиции тестовых заданий. Нарушение требований формы резко ухудшает понимаемость содержания заданий, а, следовательно, и качество измерения.

Теоретическое мышление находит отношение практиков к формам ограниченным и вредным, тормозящим развитие тестовой культуры. От качества формы зависит понимание содержания заданий, технологичность тестового процесса, точность и эффективность измерений. Нарушение требований формы является также одним из самых распространенных источников погрешностей в контрольных материалах, где нарушения формы и логики содержания заданий – явление частое, происходящее год от года. Пока нет мастерского владения формами тестовых заданий, не будет и качественных тестов.

На Западе развитие формы протекало в рамках прикладного направления педагогики, называемого Item Writing[84]. Первое описание формы заданий с выбором одного правильного ответа можно найти в трудах G.M. Whipple[85]. В США форму тестовых заданий исследовали C.W. Odell[86], H.F. Hawkes, E.F. Lindquist & C.R. Mann[87], W.S. Monroe, J.C. DeVoss & F.J. Kelly[88], H.D. Risland[89], G.M. Ruch[90], M.W. Richardson, J.T. Russel, J.M. Stalnaker & L.L. Thurstone[91], J. Follman, B. Hall, R.Wiley. & J.Hartmanh[92]. и мн. др. Немного позже, в 1920-х-1940-х годах, стали делаться попытки механизировать, а затем и автоматизировать формы контроля знаний.

В те годы экспериментальным сравнением тестовых форм в СССР успешно занимался Г.С. Костюк[93]. «Форма теста, - писал он в 1928 году, является одной из тех проблем тестирования, научное изучение и разрешение которой чрезвычайно важно и неотложно»[94]. Этот призыв был проигнорирован в то время, это был период утверждения авторитаризма. В наше время на важность формы тестовых заданий недавно обратил внимание А.Г.Войтов[95].

Опираясь на приведённые труды, автор этой статьи наметил свой подход, суть которого – изменение логической основы для заданий в тестовой форме. Если обычной основой заданий являются вопросы и ответы, то в нашей практике разработки заданий в тестовой форме используются утверждения (суждения), которые при выборе правильных ответов превращаются в истинные высказывания, а при выборе неправильных ответов - в ложные утверждения.

Число ответов желательно иметь больше, чем один. Тогда знания можно проверить шире, глубже, полнее, с меньшей вероятностью угадать один правильный ответ. А это повышает валидность и надёжность педагогических измерений[96].

Третье направление – улучшение содержания тестовых заданий. Содержание теста и его вариантов является приемлемым, если по итогам ответов на задания любого варианта одного и того же теста достигается хорошая сравнимость с другими вариантами. Иначе говоря, испытуемому должно быть всё равно, на какой вариант теста он отвечает. В контрольных материалах ЕГЭ результат сильно зависит от меры трудности заданий, доставшихся испытуемому. В то время как в хорошем тесте все варианты каждого задания сопоставимы между собой по уровню трудности, а также по содержанию учебных тем, проверяемых у каждого испытуемого.

Четвёртое направление – разработка критериев качества и эффективности педагогических измерений

Все годы развития педагогических измерений в теории рассматривались два основных критерия качества – надёжность и валидность. Эти два критерия и по сей день считаются основными. В российской практике всё ещё продолжают говорить и писать слова «надёжность и валидность тестов» вместо более правильных выражение «надёжность и (или) валидность результатов тестирования.

Оба эти критерия качества педагогических измерения, их основные составляющие – понятия, методы, и формулы - были рассмотрены во втором номере нашего журнала[97].

Помимо этих двух традиционных критерия качества результатов, в последние годы большое внимание привлёк к себе критерий объективности тестовых результатов[98]. По сути, это был самый первый критерий качества тестовых результатов, с которых начинали свою работу классики западной психометрики. Ввиду широты самого понятия «объективности» и недостижимости её полного достижения, внимание большинства исследователей переключилось на критерии надёжности и валидности. Однако с момента возникновения методологии Rasch Measurement внимание многих авторов опять привлёк критерий объективности.

Основные требования, позволяющие достигнуть объективированные результаты измерения, были сформулированы в работах последователей Г.Раша и в нашей статье. В сжатом варианте таких требований всего пять:

1. Параметры математических моделей для измерения свойств заданий и испытуемых не должны быть взаимно зависимы. Это главное научное достижение G.Rasch. Вся технология RM вытекает из свойства независимости параметров испытуемых от параметров заданий, и наоборот.

2. Метод измерения должен быть сравнительно легким, компьютеризованным, полностью, по возможности, технологичным. Это требование позволяет привлечь к проведению измерений большое число школьных педагогов и вузовских преподавателей.

3. Для начинающих исследователей считается наиболее приемлемой одномерная модель измеряемого свойства. Продвинутые авторы, имеющие подходящее математическое и статистическое образование, тяготеют к многомерным моделям измерения, которые чаще оказываются интереснее одномерных моделей.

4. Получаемые значения в процессе педагогических измерений должны отвечать требованиям линейности шкалы, что обеспечивает сравнительно удобные варианты математических аксиом и операций, а также интерпретации результатов.

5. Монотонность отображения измеряемого свойства испытуемых или заданий в числовую шкалу. Смысл этого требования прост: испытуемые, имеющие более высокий уровень подготовленности, должны получать и более высокий балл в RM[99]. Измерения по теории Rasch отвечают всем этим требованиям.

И, наконец, четвёртым, по счёту, но не по важности, стал критерий эффективности тестов и тестовых заданий. Если относительно первых трёх критериев речь шла о качестве результатов тестирования, то четвёртый критерий используется для принятия решения об эффективности каждого отдельного задания или теста в целом[100].

В процессе тестирования приходится принимать во внимание затраты времени и средств на измерение интересующего свойства испытуемых, искать возможности применения кратковременных тестов вместо длительных методов педагогического оценивания или четырёхчасового некачественного государственного экзамена.

Фактор времени – один из главных признаков различия между тестом и государственным экзаменом. Качественно разработанный тест всегда короче по времени, точнее, адекватнее для совокупности испытуемых, технологичнее, имеет меньшую погрешность измерения, объективнее, справедливее и экономнее, чем любой экзамен.

Эффективность рассматривается как комплексный критерий оценки полезности тестов[101], тестовых заданий и тестовых результатов, по широкому кругу экономических, социальных, психологических. Эффективность тестов зависит от целей, методологии, теории, методики и от текущей практики педагогических измерений.

Пятое направление развитие педагогических направлений – это развитие языка этой прикладной науки. Основные вопросы развития этого направления представлены в статье автора «Язык педагогических измерений»[102].