КРАТКИЙ АНАЛИЗ ТЕХНОЛОГИИ И РЕЗУЛЬТАТОВ

ЕДИНОГО ГОСУДАРСТВЕННОГО ЭКЗАМЕНА

Владимир Хлебников

Аннотация

В статье сделан краткий анализ технологии единого государственного экзамена (ЕГЭ). Отмечена принципиальная невозможность одновременного достижения целей итоговой аттестации и вступительных испытаний в вузы. Большое внимание уделено погрешностям результатов ЕГЭ на различных участках шкалы оценок. Обсуждаются вопросы контрольно-измерительных материалов (КИМ) ЕГЭ. Рассмотрены проблемы информационной безопасности технологии и результатов ЕГЭ. Сформулированы причины существующих проблем ЕГЭ. Намечены направления совершенствования технологий итоговой аттестации и вступительных испытаний.

Ключевые слова: тест, тестирование, единый государственный экзамен, централизованное тестирование, итоговая аттестация, вступительные испытания, погрешность измерений, информационная безопасность.

Введение

Наиболее важным событием в современной Российской системе образования является отказ от жёстких учебных планов и программ в общеобразовательных учреждениях. Сейчас каждая школа имеет свой учебный план. Государственный контроль качества обучения производится только на этапе итоговой аттестации, т.е. по окончании начальной, основной (9 классов) и полной (11 классов) школы.

Органы управления образованием формально не вмешиваются в процесс обучения. Да и текущий контроль над учебными достижениями их мало интересует.

В настоящий момент обострились две другие проблемы.

Первая – это коррумпированность при отборе поступающих в высшие учебные заведения для обучения за счет бюджета.

Вторая – это отсутствие каких-либо нормативно определённых ориентиров для выставления отметок (текущих и итоговых) за учебные достижения учащихся общеобразовательных учреждений. Российская школа не имеет руководящих документов о том, за какие знания учащимся можно выставлять отметки «2», «3», «4» и «5». У каждого учителя, методиста или руководителя управления образованием по этому вопросу имеются собственные соображения.

Более того, традиционная для России пятибалльная система школьных отметок давно переродилась в четырёхбалльную, т.к. отметки «1» практически не применяется. Отметка «2», по крайней мере, в итоговой аттестации, тоже не выставляется. В итоге имеем шкалу «3», «4» и «5», которая постепенно сужается до однобалльной – «4». Это связано с тем, что отметка «3» нежелательна, т.к. вызывает подозрение в том, что за ней скрывается отметка «2». Отметка «5» привлекает к себе внимание и учителю спокойней вместо нее ставить оценку «4». Более примитивную шкалу невозможно придумать. Это привело к тому, что Российская система оценок плохо отражает учебные достижения, как отдельных учащихся, так и групп.

Российское образование остро нуждается в современной шкале оценок учебных достижений. Почти во всех республиках СНГ уже введена десятибалльная система школьных оценок.

Вместе с этим нужно разработать и ввести в действие требования, предъявляемые к знаниям школьников по всем предметам и темам для выставления соответствующих отметок. За восемь лет эксперимента по введению ЕГЭ ничего подобного не делалось. Ни для кого не является секретом, а, наоборот, стала притчей во языцех нескрываемая помощь выпускникам со стороны учителей на итоговой аттестации. Всё это свидетельствует о том, что Российская система образования нуждается в механизме получения объективных оценок учебных достижений – как для целей итоговой аттестации (средняя школа), так и для обеспечения социальной справедливости при приёме на обучение в вузы за счёт средств бюджета.

Единый государственный экзамен (ЕГЭ). Требования.

Велико значение слова «единый». Очевидно, что едиными для всех участников экзамена должны быть требования к учебным достижениям, единая структура экзаменационных материалов (по предметам), единая процедура проведения и обработки результатов ЕГЭ, единая методика оценивания первичных результатов ЕГЭ (ответов на задания измерительных материалов).

Кроме того, должны быть обеспечены:

- научная обоснованность технологии и методик оценивания учебных достижений учащихся,

- высокая надежность результатов измерений. Высокая погрешность измерений учебных достижений по результатам ЕГЭ (особенно в зоне высших и низших баллов) препятствует достижению надёжности результатов ЕГЭ.

- независимость результатов ЕГЭ от:

• • использования множества неравносложных вариантов измерительных материалов,

• • места и времен проведения ЕГЭ,

• • состава исполнителей, привлекаемых для проведения ЕГЭ и обработки результатов,

- абсолютная информационная безопасность экзаменационных материалов, технологии проведения ЕГЭ и обработки его результатов от несанкционированного вмешательства,

- прозрачность всего процесса проведения ЕГЭ,

- соответствие требований итоговой аттестации и вступительных испытаний в вузы к КИМам и технологии проведения ЕГЭ,

- общественное согласие с результатами ЕГЭ и статусом их использования.

Перечисленные требования при проведении эксперимента по введению ЕГЭ не оценивались никогда!

Проведём краткий анализ той технологии, которая с 1 января 2009 года по закону будет использована для решения проблем Российского образования.

Результаты ЕГЭ

Главное в ЕГЭ – это результаты. Что же измеряет ЕГЭ?!

Можно с уверенностью сказать, что смысл оценок по результатам ЕГЭ (тестовый балл) не понимает практически никто.

Тестовый балл, выставляемый по результатам ЕГЭ, рассчитывается по методике, разработанной ранее в Федеральном центре тестирования. Методика создавалась для оформления результатов централизованного абитуриентского тестирования – акции сугубо добровольной как для учащихся, так и для вузов, учитывавших результаты централизованного тестирования (ЦТ).

Результаты тестирования учащихся расставлялись в упорядоченный ряд по тестовым баллам, определённым в зависимости от количества верных ответов и сложности используемых вариантов тестов. Методика использует некоторые теоретические положения, устоявшиеся в зарубежных научных исследованиях. Хорошая научная база позволяла получать результаты, безусловно принимаемые вузами для отбора наиболее подготовленных поступающих.

Именно такая методика расчета тестовых баллов была перенесена из централизованного абитуриентского тестирования в единый государственный экзамен. С одной существенной поправкой. Если для централизованного тестирования учитывалось, что различные варианты тестов могут иметь различную меру трудности, то для ЕГЭ прежним руководством Рособрнадзора было дано указание усреднить тестовые баллы, полученные при использовании разных вариантов КИМ.

Поясним, что это означает.

Пусть два учащихся с примерным одинаковым уровнем подготовленности участвовали в централизованном тестировании. Каждый из них получил свой вариант теста. Варианты имели разную меру трудности. Одному абитуриенту достался вариант легче, другому - труднее. Это явление весьма распространенное, т.к. создать даже два варианта теста одинаковой трудности очень сложно.

Методика централизованного тестирования это улавливала и, не взирая на разное количество верных ответов, устанавливала для таких испытуемых примерно одинаковые тестовые баллы. Это справедливо. И наука это обеспечивает.

В ЕГЭ этого нет. Все участники, набравшие одинаковое число верных ответов (исходных баллов), получат одинаковый балл по ЕГЭ, вне зависимости от трудности доставшегося варианта КИМа.

А эти варианты часто сильно отличаются друг от друга по трудности! Специалисты это хорошо знают.

Такой ЕГЭ не гарантирует точные и справедливые результаты. Следовательно, результаты ЕГЭ нельзя использовать для отбора поступающих в вузы, ввиду их научной необоснованности.

ЦТ, ЕГЭ и итоговая аттестация

Плохо обстоит дело и с использованием результатов ЕГЭ для целей итоговой аттестации. Повторим, что методика расчёта тестовых баллов ЕГЭ определяет уровень подготовленности учащихся, сравнивая их знания друг с другом, но не сравнивая с требованиями учебной программы. Используемая при этом методика предназначена только для отбора поступающих в вузы.

Для целей итоговой аттестации должна быть использована критериально ориентированная интерпретация результатов, при которой определяется степень освоения выпускником образовательной программы по предмету.

Сделать суждение о степени освоения школьного предмета для итоговой аттестации по результатам КИМов ЕГЭ в принципе невозможно.

В Центре тестирования для итоговой аттестации разрабатывались совсем иные, итоговые тесты с критериально – ориентированной интерпретацией результатов. Результаты такого тестирования обрабатывались и интерпретировались иначе, чем результаты абитуриентского тестирования.

До сих пор, никакие даже самые продвинутые тестологи мира не смогли создать тест, результаты которого могли бы интерпретироваться одновременно как нормативно, так и критериально ориентированно. А также могли бы быть использованы для целей итоговой аттестации и для отбора наиболее подготовленных поступающих в вузы.

Наши коллеги в Армении, Азербайджане, Белоруссии, Казахстане и Узбекистане не совмещают итоговую аттестацию со вступительными испытаниями. Государственные испытания в тестовой форме проводятся только для отбора поступающих в вузы, причем с привлечением служб национальной безопасности.

Россия пошла иным путём, который при кажущейся привлекательности, не имеет последователей.

Отмеченные недостатки являются основными, препятствующими достижению поставленных целей ЕГЭ.

Можно ли исправить имеющиеся недостатки?

Для отбора поступающих в вуз проблема решается просто. Для этого достаточно изменить методику обработки исходных баллов таким образом, чтобы она учитывала различную сложность используемых вариантов. Это сделать нетрудно, так как такая методика существует и много лет используется при проведении абитуриентского централизованного тестирования.

Многочисленные иные недостатки ЕГЭ при этом остаются, но о них скажем позднее.

Для целей итоговой аттестации проблема с ЕГЭ ремонту не подлежит. Итоговая аттестация требует других методов оценивания и методик обработки результатов.

Процессы итоговой аттестации и отбора поступающих в вузы несовместимы. Их необходимо разделить.

Перевод тестовых баллов ЕГЭ в пятибалльную шкалу для целей итоговой аттестации сейчас осуществляется произвольно. В первые годы эксперимента по введению ЕГЭ за основу бралось такое правило: количество двоечников и отличников устанавливалось по десять процентов от общего числа участников. Троечников и хорошистов – по сорок процентов от общего числа участников.

В последующие годы доля учащихся с различными отметками во избежание нелепицы корректировалась. Так, например, считается неправильным ставить отметку «удовлетворительно» по математике за три-четыре верных ответа. На простейшие вопросы в части «А» даже восьмиклассник даст три-четыре верных ответа. Учащиеся 9-10-ых классов сразу догадаются, что тройка им уже гарантирована, и далее всерьез учиться не будут. Вот и пришлось для сохранения приличий ставить тройку за большее число верных ответов. А это привело к тому, что доля двоечников по математике возросла до стабильного по годам уровня в 22 – 23 процента от общего числа участников. Так учат у нас в школе математике. Как могли такие учащиеся быть допущенными к итоговой аттестации?

Погрешности измерений

Рассмотрим вопрос о погрешности оценок учебных достижений, получаемых при проведении ЕГЭ.

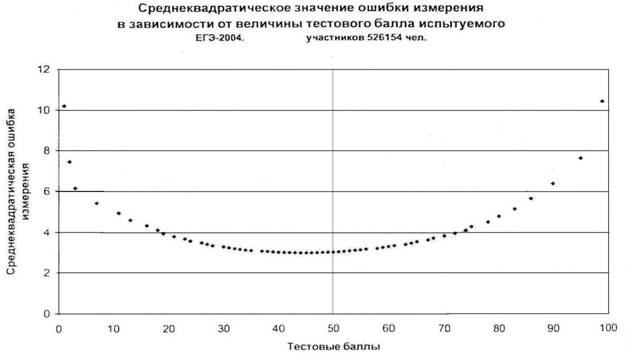

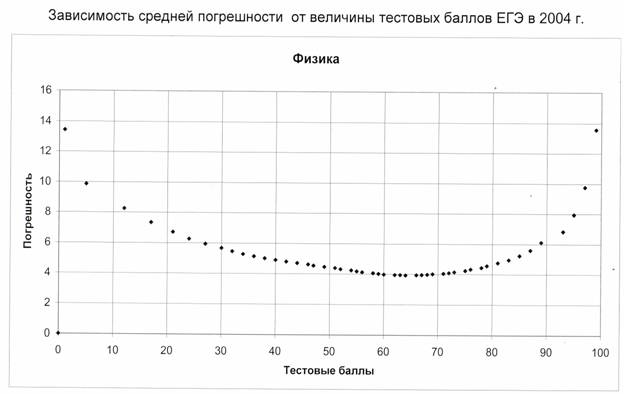

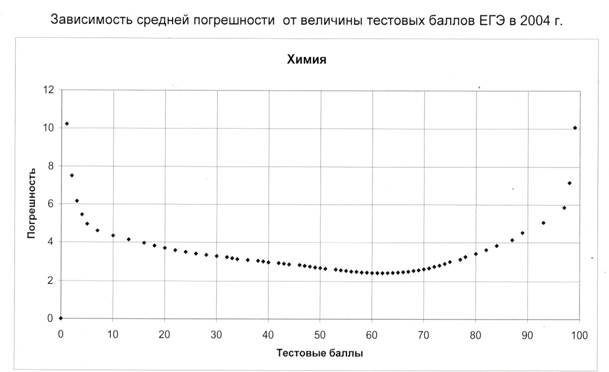

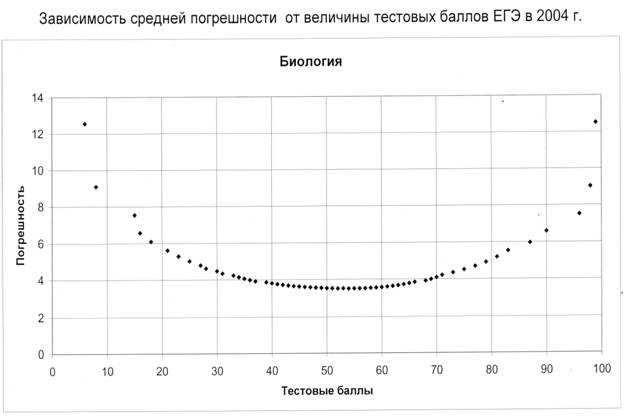

В Федеральном центре тестирования проводились расчеты погрешностей результатов ЕГЭ. Было определено, что в середине шкалы измерений (от 40 до 60 баллов) значение погрешности практически по всем предметам составляет ± 3 тестовых балла. Погрешности возрастают по мере смещения в сторону низких и высоких оценок. Например, в районе 90 баллов погрешность достигает десяти тестовых баллов (см. рис. 1 - 4).

Русский язык

Рис. 1

Рис. 2

Рис. 3

Рис. 4

Эта погрешность неустранима в нынешнем ЕГЭ, т.е. как говорят математики, - это погрешность метода. На практике это означает, что вуз, выбирая из двух поступающих с результатами 84 и 86 баллов по предмету, отдает предпочтение, казалось бы, лучшему – 86 балльному результату. В некоторых вузах результат меньше 85 баллов вообще не рассматривается. А на самом деле результаты этих поступающих 84 ± 5 и 86 ± 5 баллов, и кто из них лучше знает предмет - не очевидно.

Если тестовые баллы испытуемых отличаются друг от друга на величину меньшую, чем погрешность измерения, то делать суждение о превосходстве того или иного результата не корректно. Из этого следует, что ЕГЭ плохо дифференцирует испытуемых в наиболее важной для приема в вуз зоне – области наивысших тестовых баллов. Имеет ли право ЕГЭ на систематические неточности такого размера? Ничего не подозревающим выпускникам школ и приёмным комиссиям вузов величина тестового балла объявляется без тени сомнения.

Неучёт факта, что погрешность измерения в области высоких баллов недопустимо велика, приводит к тому, что результаты, указанные в свидетельствах ЕГЭ, не отражают реального уровня подготовленности испытуемых. Это зачастую вызывает неосознанное, но интуитивно верное возмущение выпускников и их родителей.

Как уменьшить погрешность оценок ЕГЭ? Есть два способа.

Первый. Увеличить число заданий в КИМе. Но это не технологично. КИМы, содержащие сотни заданий разного уровня трудности, сложно разрабатывать и ещё труднее использовать.

Второй. Разрабатывать и использовать варианты (батареи) теста, небольшие по количеству заданий и различные по уровню трудности. Этот способ предпочтительнее.

Минимизация погрешности измерений тесно связана с проблемами оценивания (шкалирования) результатов тестирования. Это самые наукоёмкие вопросы. За восемь лет эксперимента по введению ЕГЭ не было сделано ничего для создания и развития науки о педагогических измерениях в России. Руководители образования видимо считали, что для ЕГЭ наука не нужна. Это неверно.

Экзаменационные материалы ЕГЭ

Обсудим кратко контрольные измерительные материалы (КИМы), используемые при проведении ЕГЭ. Их разрабатывает специализированное государственное учреждение Федеральный институт педагогических измерений (ФИПИ). Ежегодно для ЕГЭ по каждому предмету необходимо разработать десятки, а по математике и по русскому языку по сотне оригинальных вариантов КИМов высокого качества. Разные варианты тестов должны быть в идеале одинаковой трудности и с одинаковыми измерительными свойствами. Эта задача не выполнима! Общественность не знает, по каким параметрам и измерительным свойствам отбираются КИМы ЕГЭ. Материалы сдаются в тираж в феврале – марте. Удовлетворительное опробывание (не путать с апробацией) материалов к этому сроку провести невозможно. Измерительные свойства КИМов, используемых в ЕГЭ, не знает никто - ни до, ни после экзамена.

Ввиду высокого статуса ЕГЭ, к разработке измерительных материалов потянулось множество специалистов–предметников. Для них ЕГЭ – это и заработок, и престиж. Выбрать было из кого. Отобрали самых «маститых». Ну не могут они делать простенькие задания. И в части «С» появились задания чрезмерно большой трудности, причем не лучшего качества, за исключением задач типа С3. Ну и кто может их все выполнить?

Все задания части «С» выполняют единицы испытуемых, а двоечников по математике более двадцати процентов от общего числа участников ЕГЭ, т.е. более двухсот тысяч человек. Зачем задания с такой трудностью тиражировать, рассылать по всей стране, собирать предметные комиссии для проверки, расходовать государственные средства? Все это ради единичных случаев, в то время, как сотни тысяч выпускников требуют более пристального внимания. Для чего делается такой разброс трудности заданий? Видимо у руководителей эксперимента по введению ЕГЭ была уверенность, что небольшим числом заданий возможно с высокой степенью точности оценить знания всех учащихся - и посредственных, и продвинутых. Но это невозможно. Кто дал такой совет?

Структура материалов ЕГЭ плохо продумана и нуждается в переработке.

Казалось бы, что качество КИМов должно расти вместе с опытом их разработки. Но этого не происходит. Нарекания со стороны специалистов были ранее, есть и сейчас. Не вдаваясь в подробности, можно смело утверждать, что по процедуре разработки экзаменационных материалов ЕГЭ необходим соответствующий государственный стандарт, утверждённый Агентством по техническому регулированию (бывший Госстандарт). Содержание экзаменационных материалов, как и прописано в законе, остается в ведении системы образования.

Но процесс разработки экзаменационных материалов, требования к качеству и их измерительным свойствам, трудности, способности дифференцировать учащихся по степени подготовленности и прочим свойствам нужно определить и описать в соответствии с хорошо продуманной процедурой разработки стандартов. Иначе не понятно, что за материалы используются при проведении ЕГЭ. Неизвестны их измерительные свойства. С какой погрешностью они определяют уровень подготовленности учащихся?

Никто не знает ответа на эти вопросы. Никогда не публикуются материалы с характеристиками используемых тестов. На Западе такие публикации совершенно обязательны. Руководители Рособрнадзора такие задачи перед исполнителями не ставят. А те и довольны. Сами КИМы разрабатывают, сами же их и хвалят. Хотя и признают, что бывают отдельные недостатки.

Информационная безопасность

Исключительно большое значение для ЕГЭ имеет проблема информационной безопасности. Несанкционированное вмешательство в любой технологический элемент ЕГЭ может исказить результаты не только одного испытуемого, но и групп на уровне класса или школы. Распространение злоумышленниками по каналам Интернет накануне экзамена похищенных вариантов тестов и ответов к ним может привести к искажению результатов ЕГЭ в целых регионах. Выпускники могут несправедливо получить высокие тестовые баллы, и аннулировать их будет невозможно. В вузы будут зачислены совсем не лучшие поступающие. Заметим, что самый большой вред – преждевременное раскрытие экзаменационных материалов в Интернете – совершают люди с наименьшей материальной мотивацией – хулиганы.

Нередки случаи решения экзаменационных заданий группами преподавателей, собранных в якобы опечатанных кабинетах пунктов проведения ЕГЭ. Возможна подмена бланков ответов избранных испытуемых из резервных комплектов бланков и т.д. Сколь бы ни была изощрённой технология ЕГЭ, все мер предосторожности предусмотреть невозможно. Свидетельством этого являются аномальные факты массового получения чрезвычайно высоких результатов ЕГЭ.

Например, в 2005 году в ряде сельских районов Башкирии на ЕГЭ по математике оценку «отлично» получили до 85 процентов экзаменующихся. В том же году в одном из районов Кировской области (п. Кильмезь) были получены самые высокие в стране результаты по русскому языку. Такие результаты выпускникам Москвы и Санкт – Петербурга не снились.

Досадно, что зафиксировать нарушения на месте или отменить самые вопиющие результаты невозможно. Не позволят установленные организаторами правила и круговая порука.

Вмешательство в результаты ЕГЭ возможно! Это реальный факт. Технология ЕГЭ не даёт никаких гарантий того, что несанкционированное вмешательство исключено.

Высокий статус ЕГЭ создаёт сильнейшую мотивацию к получению высоких результатов у выпускников и их родителей.

С другой стороны, по долгу службы учителя и руководители органов управления образованием тоже далеко не безразличны к тому, как выглядят их выпускники и подведомственные учреждения по результатам внешнего контроля, т.е. ЕГЭ.

Имеем уникальную ситуацию – стремление всех лиц, причастных к ЕГЭ, к высоким результатам. А это сила не малая.

Уже выработался простой и безопасный способ всё устроить. Суть его такова. За несколько дней до экзамена учителя проводят консультации для выпускников. В органы управления образованием субъектов Федерации к этому времени уже поступают материалы ЕГЭ по соответствующему предмету. Материалы поступают с запасом, так что досрочное вскрытие одного «Секьюрпака» и ознакомление с его содержанием проходят совершенно незаметно. Всем известно, что по каждому предмету на регион имеется всего лишь пять оригинальных вариантов КИМов. Остальные варианты формируются путем перемешивания заданий из пяти оригинальных.

Далее совсем просто. Из реальных материалов ЕГЭ специалисты – предметники быстро делают похожие варианты – аналоги. Материалы тиражируются и рассылаются в школы для использования на консультациях. Там материалы решаются. Через пару дней выпускники на экзамене получают варианты КИМов, содержащие задания очень похожие на те, которые разбирались на консультации. Абсолютно точно повторить решения и указать верные ответы на все задания не сможет никто, но можно гарантировать, что в целом весь массив выпускников получит более высокие баллы ЕГЭ. Выбросов аномально высоких результатов не будет. Все довольны – выпускники, родители, учителя, руководители и пр. Выявить нарушение невозможно.

Так изящно вскрывается система информационной безопасности ЕГЭ. Преодолеть её возможно только одним способом – абсолютно отстранить от проведения ЕГЭ всех работников системы образования – от министра до дворника!

А без этого вся суета с ЕГЭ – пустые хлопоты.

Предтеча ЕГЭ

Лица, знающие жизнь российской системы образования за последние 10 – 15 лет, сразу заметят, что основные элементы ЕГЭ были реализованы в рамках централизованного тестирования за несколько лет до появления идеи ЕГЭ. Централизованное тестирование проводилось сугубо добровольно по желанию учащихся и образовательных учреждений. Акция не требовала из бюджета ни копейки денег, а результаты признавались более чем шестью сотнями вузов России. Разрабатывались тесты, проводилось тестирование и обрабатывались результаты отдельно абитуриентского и аттестационного тестирований.

Очевидно, что ЕГЭ - не оригинальное нововведение, а всего лишь повторение, но на государственном уровне, централизованного тестирования. Как всякая копия, она хуже оригинала.

Динамично развивавшееся централизованное тестирование переломило в конце девяностых годов прошлого века негативное отношение педагогической общественности к тестовому способу контроля знаний, заслужило признание и уважение современными технологиями разработки тестов, проведением одномоментного тестирования по всей стране и эффективной обработкой результатов тестирования.

Именно в рамках централизованного тестирования были разработаны современные научные методики шкалирования результатов тестирования при использовании большого количества вариантов неравносложных тестов. Начали зарождаться научные основы отечественной теории измерений учебных достижений учащихся. Ставились вопросы минимизации погрешностей измерений за счет использования более совершенных тестов и батарей тестов, предназначенных для работы с учащимися разной степени подготовленности.

Возникло понимание того факта, что одним КИМом нельзя одинаково хорошо измерить подготовленность элитных, средних и учащихся с отклонениями в состоянии здоровья. Такой КИМ должен состоять из сотен вопросов, что нетехнологично, а короткий КИМ будет давать большую погрешность измерений.

Наиболее плодотворные идеи и наработки централизованного тестирования для ЕГЭ оказались невостребованными. Чиновники, организующие ЕГЭ, науку и детали технологии видеть не хотели. Все усилия уходили на то, чтобы как-то увязать между собой массу организационных вопросов широкомасштабной акции. Важен был формальный результат – КИМы привезли в школы, раздали выпускникам, собрали бланки ответов и пропустили их через сканеры. А что при этом получится – не столь важно. Легко заметить, что такой ЕГЭ – это осовремененный вариант министерской контрольной работы, великое множество которых проводилось в школах бессчётное число раз. Эффект от этих контрольных был нулевой. Иное дело ЕГЭ. Его отрицательное влияние уже велико.

Причины, следствия и возможности

Главная проблема ЕГЭ состоит в исключительно высоком статусе результатов. Целью школы стало теперь не обучение и развитие личности учащихся, а погоня за высокими показателями при сдаче ЕГЭ. Учебный процесс в старших классах существенно меняется. Школа стала не учить, а натаскивать на конкретные задания, вопросы, темы. Учебная программа меняется. Фактически сокращается число часов преподавания математики. Учитель вместо объяснения материала вынужден с февраля месяца натаскивать выпускников на задания в форме ЕГЭ. Литература перестала быть обязательным предметом. Подвижки происходят по всем дисциплинам, контроль за освоением которых происходит в форме ЕГЭ.

Из этого следует, что необходимо развести между собой итоговую аттестацию и вступительные экзамены в вузы. Не надо грузить школу проблемами предметных комиссий вузов.

Рособрнадзор не надзирал, а взял на себя производственные функции и руководил созданием ЕГЭ. Большой административный ресурс гарантировал плановое вхождение регионов в эксперимент по введению ЕГЭ, поддержку ректоров вузов и всеобщее «Одобрям-с».

Возникает вопрос! Почему результаты ЕГЭ будут использоваться только для двух сугубо практических и одномоментных целей? Полученная при проведении ЕГЭ информация – если она точна и достоверна, – просто бесценна. Её можно использовать для множества полезных дел. Уровень подготовленности выпускников был бы известен как для всей России, так и для каждого региона, населённого пункта, школы, класса. Наблюдая за этими показателями несколько лет, можно было бы понять, куда движется наше образование в целом по стране, региону, населённому пункту и т.д.

Имея информацию о системе образования – зная социальный состав учащихся и преподавателей, их профессиональные характеристики (возраст, стаж квалификацию и пр.), зная уровень материально – технического обеспечения школ, используемые учебники, методики, можно было бы понять причины, выявленных с помощью ЕГЭ результатов.

В результате анализа полученной информации можно было бы принимать обоснованные управленческие решения, направленные на достижение главной цели – повышения качества Российского образования. А при более качественном образовании и страна становится могучее, и граждане богаче.

Всё это возможно при правильном сконструированном ЕГЭ. Для достижения такой цели ЕГЭ безусловно нужен! Но если руководители образования говорят, что при введении ЕГЭ «Марь Иванна» больше не сможет, проходя по рядам, делать подсказки экзаменующимся, то это слишком мелкая постановка задачи.

Изо всего множества практических применений результатов ЕГЭ выбраны только два – выпускные в школах и вступительные экзамены в вузы. Колоссальная польза от полученных результатов ЕГЭ пропадает втуне! Экзамены прошли, страсти утихли, и всё на этом кончается. Работа системы образования продолжается как и прежде. Ни на финансовые потоки, ни на кадровые решения и оргвыводы результаты ЕГЭ никак не влияют.

Гора родила мышь!

Основные выводы

ü Оценки в свидетельствах ЕГЭ, которые должны стать единственным критерием для приема в государственные вузы России, научно не обоснованны. Они определены без учета сложности вариантов тестов, что в принципе приводит к завуалированной несправедливости.

ü Использование результатов ЕГЭ для итоговой аттестации в школах недопустимо, так как ЕГЭ не оценивает степень освоения учащимися предмета. Методика расчета тестовых баллов ЕГЭ для этого совсем не предназначена. ЕГЭ тут вообще не причем. Школьные отметки по методике Рособрнадзора можно выставлять без всякого ЕГЭ. Для этого управлениям образования надо указать установленный свыше процент двоек, троек, четвёрок и пятёрок по предметам. Абсурд? Да! Но именно так всё и происходит. Только после проведения дорогостоящей процедуры ЕГЭ.

Доля учащихся, которым выставляется соответствующая школьная отметка, волюнтаристски назначается чиновниками. И ведь все это знают, но молчат.

Для проведения ЕГЭ ежегодно привлекается более миллиона человек – выпускников и организаторов. Тысячи преподавателей – предметников разрабатывают задания. Материалы печатаются, упаковываются, рассылаются. Ответы обрабатываются. Расходуются громадные государственные средства. И всё впустую. Вся акция ЕГЭ методически не продумана и своих целей в принципе достичь не может.

В этом не ничего удивительного, т.к. при проведении эксперимента по введению ЕГЭ серьёзной подготовительной работы не проводилось. Концепции, технического задания, рабочего проекта, цели, задач, рабочих гипотез при проведении эксперимента по введению ЕГЭ не было. Нет критериев, по которым можно судить об успешности эксперимента.

Резюме

Вводимый законом с

Введение ЕГЭ целесообразно приостановить.

Необходимо с учетом накопленного опыта пересмотреть его основные положения. Создать концепцию по оцениванию учебных достижений учащихся, получить общественное согласие, разработать и внедрить новые методы и технологии оценивания. Создать в России научную школу по оценке учебных достижений учащихся.

Не допускать возврата к ситуации десятилетней давности, когда оценки в школах и при поступлении в вузы отдавались на откуп тем же школам и вузам.

Это означало бы не только признание ошибок, допущенных при введении ЕГЭ, но и отбросило бы Российское образование на много – много лет назад. Нельзя предавать забвению труд сотен и тысяч энтузиастов по созданию в России научных и производственных основ объективного оценивания учебных достижений. Это было бы регрессом и ошибкой.